Paano Gumamit ng Mga Proxies para sa Pag-scrape ng Web Nang Hindi Naba-block

Tingnan ang Mabilis

Ang makatwiran at epektibong paggamit ng mga proxy ay makakatulong sa iyong web scraping nang hindi naba-block. Tumuklas ng mga tip upang mapanatili ang pagiging hindi nagpapakilala at mag-scrape ng data nang walang putol. Handa nang i-optimize ang iyong proseso ng pag-scrape? I-explore ang aming gabay at simulan ang pag-scrape nang mas matalino ngayon!

Ang Web Scraping ay isang pamamaraan na ginagamit upang kunin ang data mula sa mga web page. Gumagana ito sa pamamagitan ng pagpapadala ng mga kahilingan upang i-target ang mga website na katulad ng ginagawa ng isang browser. Ito ay nagbibigay-daan sa pagkuha ng iba't ibang impormasyon tulad ng teksto, mga larawan, at mga link.

Ang web scraping ay may ilang mga application:

-

E-commerce: Pinapadali ang pagsubaybay sa presyo, pagtulong sa mga negosyo at consumer na gumawa ng mas mahusay na mga desisyon sa pagbili at magtakda ng mga mapagkumpitensyang presyo.

-

Balita: Pinapagana ang pagsasama-sama mula sa iba't ibang mapagkukunan, na nagbibigay ng komprehensibong pangkalahatang-ideya ng balita sa isang platform.

-

Lead Generation: Tumutulong sa mga negosyo sa paghahanap ng mga potensyal na customer sa pamamagitan ng pagkuha ng nauugnay na data, at pagpapahusay sa pagiging epektibo ng marketing.

-

SEO: Ginagamit para sa pagsubaybay sa mga pahina ng resulta ng search engine at pag-optimize ng nilalaman at mga diskarte sa website.

-

Panalapi: Sa mga application tulad ng Mint (US) at Bankin' (Europe), pinapayagan nito ang pagsasama-sama ng bank account para sa streamlined na personal na pamamahala sa pananalapi.

-

Pananaliksik: Tumutulong sa mga indibidwal at mananaliksik na lumikha ng mga dataset na kung hindi man ay hindi naa-access, na nagpo-promote ng akademikong pananaliksik at mga proyektong batay sa data.

Ngunit marami ang pagod sa pagkakaroon ng mga proyekto sa web scraping na na-block o naka-blacklist. Sa katunayan, ang pagsunod sa pinakamaraming pinakamahusay na kagawian hangga't maaari ay ang kailangan lang upang maiwasan ang hindi matagumpay na proseso ng pagkuha ng data sa web.

Ang trick sa pagsasagawa ng matagumpay na web scraping ay upang maiwasan na tratuhin tulad ng isang robot at lampasan ang mga anti-bot system ng site. Ito ay dahil hindi tinatanggap ng karamihan ng mga website ang pag-scrape ng data at magsisikap na harangan ang proseso.

Tutulungan ka ng post na ito na maunawaan ang iba't ibang piraso ng impormasyon na ginagamit ng mga website para maiwasang ma-crawl ang impormasyon, at kung anong mga diskarte ang maaari mong ipatupad upang matagumpay na malampasan ang mga anti-bot na hadlang na ito.

Piliin ang Mga Tamang Proxies

Ang pangunahing paraan ng pag-detect ng mga website ng mga web scraper ay sa pamamagitan ng pagsuri sa kanilang mga IP address at pagsubaybay kung paano sila kumikilos.

Kung may nakita ang server ng kakaibang gawi o hindi malamang na dalas ng mga kahilingan, atbp. mula sa isang user, haharangin ng server ang IP address na iyon sa muling pag-access sa site.

Dito ginagamit ang isang proxy server ay pumapasok. Binibigyang-daan ka ng mga proxy na gumamit ng iba't ibang mga IP address para ipakita na ang iyong mga IP address ay lumalabas sa mundo. Nakakatulong ito upang maiwasan ang pagtuklas at pagharang.

Upang maiwasan ang pagpapadala ng lahat ng kahilingan mula sa parehong IP address, inirerekomenda kang gumamit ng serbisyo sa pag-ikot ng IP, na nagtatago ng totoong IP kapag nagko-crawl sa data.

Gayundin, upang mapataas ang rate ng tagumpay, dapat piliin ng isa ang tamang proxy. Halimbawa, para sa mas advanced na mga site na may mga mekanismong anti-crawl, mas naaangkop ang mga residential proxy.

Nararapat tandaan na ang kalidad ng iyong proxy server ay maaaring makaapekto nang malaki sa tagumpay ng iyong data crawl, kaya sulit na mamuhunan sa isang mahusay na proxy server.

ay makakatulong sa mga negosyo na magsagawa ng web scraping nang hindi natukoy o na-block. Nalalampasan ng kanilang mga proxy ang mga geo-restrictions, iniikot ang mga IP address, at nagsasagawa ng pag-scrap nang malaki nang hindi nakakaabala sa normal na operasyon ng target na website.

Sa mahigit 80 milyong totoong residential IP mula sa 195 na bansa, ang mga proxy ng IPOasis na nag-scrap ng mga proxy ay nagbibigay ng flexibility at scalability na kailangan para sa anumang proyekto sa web scraping. Hindi mo na kailangang mag-alala na ma-block muli habang nangongolekta ng pampublikong data sa web.

Bukod pa rito, gumaganap ang mga proxy ng IPOasis sa mga peak time at malalaking sukat, na tinitiyak na palaging nasa mga customer ang mga proxy na kailangan nila anumang oras. Iwasang ma-flag sa pamamagitan ng paggamit ng walang limitasyong mga session at pagbabago ng mga lokasyon ng IP nang madalas kung kinakailangan. Magtiwala sa pagiging maaasahan at pagiging epektibo ng pag-scrap ng mga proxy para sa mga pangangailangan sa pangongolekta ng data.

Pamahalaan ang Mga Rate ng Kahilingan

-

Mabagal na mga kahilingan: Dahil kailangan mong gayahin ang pag-uugali ng mga normal na user, iwasang magpadala ng malaking bilang ng mga kahilingan sa napakaikling panahon. Walang tunay na user na nagba-browse sa isang website sa ganitong paraan, at ang pag-uugaling ito ay madaling matukoy ng mga diskarteng anti-crawl. Halimbawa, kung ang mga taong user ay karaniwang naghihintay ng ilang segundo sa pagitan ng mga pag-load ng page, dapat mong i-space out ang mga kahilingan nang naaayon. Ang isang magandang tuntunin ng thumb ay limitahan ang bilang ng mga kahilingan kada minuto depende sa katangian ng site.

-

I-randomize ang agwat ng kahilingan: ipakilala ang mga random na pagkaantala sa pagitan ng mga kahilingan, mula sa ilang segundo hanggang ilang minuto upang pataasin ang randomness upang maiwasan ang pagtuklas. Gagawin nitong mas kamukha ng mga tunay na user ang iyong mga pattern ng trapiko, na maaaring gumugol ng magkakaibang tagal ng oras sa pagitan ng mga pagkilos sa site. Maaari kang gumamit ng programming function upang bumuo ng mga random na numero sa loob ng isang hanay upang itakda ang pagkaantala ng oras sa pagitan ng mga kahilingan.

Magtakda ng Mga Wastong Header

-

String ng User-Agent: Ang header ng User-Agent ay nagsasabi sa site kung aling browser at operating system ang ina-access ng user. Ang isang paraan para flexible na ilapat ang diskarteng ito para maipakitang nagmumula sa iba't ibang browser at device ang iyong mga kahilingan ay ang paggamit ng maraming string ng User-Agent. Halimbawa, maaari mong i-rotate ang User - Agent string para sa Chrome sa Windows, Firefox sa Mac, at Safari sa iOS.

-

Ang Referrer Header: Ang Referrer Header ay isang bahagi ng HTTP header. Ginagamit ito upang tukuyin ang web page kung saan sinimulan ang isang kahilingan. Sa madaling salita, kapag nag-navigate ang isang browser mula sa isang web page patungo sa isa pa, ginagamit ito upang tukuyin ang web page kung saan sinimulan ang kahilingan. Ang browser ay nagna-navigate mula sa isang web page (ang source page) patungo sa isa pang web page (ang patutunguhang pahina) at nagpapadala ng kahilingan, ang Referrer Header ay nagsasabi sa patutunguhang pahina kung saan nanggaling ang kahilingan. Ang pag-set up ng wastong Referrer ay maaaring gawing mas lehitimo ang iyong mga kahilingan. Kung naghahanap ka ng page ng produkto sa isang e-commerce na site, maaari mong itakda ang Referrer na mag-link sa page ng kategorya ng page ng produkto. Nakakatulong ang mga diskarteng ito na itago ang iyong aktibidad sa pag-crawl at lumikha ng higit pang pakikipag-ugnayan ng tao sa site, sa gayon ay pinapaliit ang mga pagkakataong mag-trigger ng mga anti-bot defense.

Gumamit ng Headless Browser

Ang walang ulo na browser ay isang mahusay na tool para sa web scraping nang hindi nagpapalitaw ng mga anti-bot system. Hindi tulad ng mga karaniwang web scraping library, ang mga walang ulo na browser tulad ng Puppeteer o Selenium ay kinokopya ang pagba-browse ng tao sa pamamagitan ng paglo-load ng kumpletong mga web page, kabilang ang JavaScript at dynamic na nilalaman.

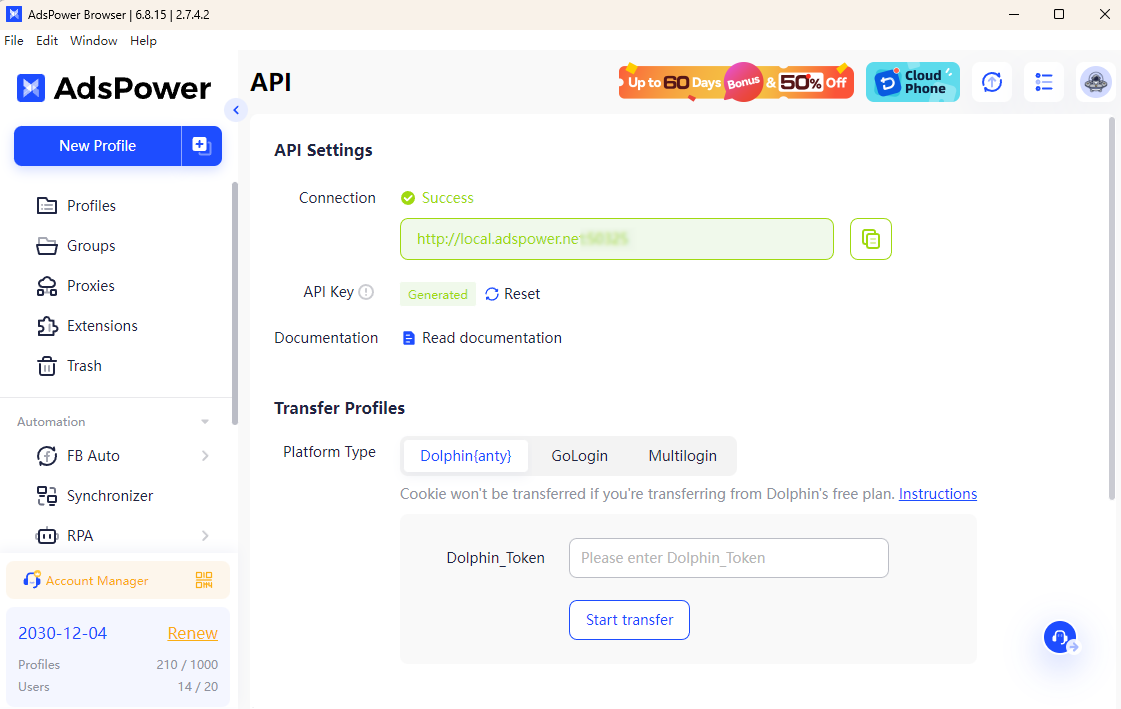

Kapag ipinares sa magiging mga browser ng pag-scrap ng AdsPower"> mabisa. Binibigyang-daan ka ng AdsPower na simulan ang headless modena may headless at API-key. Gamit ito, maaari mong i-configure ang mga natatanging fingerprint ng browser at walang putol na pagsasama-sama ng mga proxy, na nagpapahirap sa mga website na makita ang automated na aktibidad. Nagbibigay ang kumbinasyong ito ng pinahusay na anonymity at binabawasan ang panganib na ma-block.

Sa AdsPower, maaari mong gayahin ang tunay na gawi sa pagba-browse habang iniikot ang mga IP at pinamamahalaan ang maraming account nang walang kahirap-hirap. Tinitiyak nito ang maayos na pag-scrape, kahit na sa mga site na may mahigpit na anti-crawling na mekanismo, na ginagawang medyo matagumpay at secure ang iyong mga proyekto sa web scraping.

Gamit ang mga praktikal na paraan sa itaas, maaari mong i-scrape ang data ng website nang hindi naharangan. Handa nang pahusayin ang iyong diskarte sa pag-scrape sa web? Simulan ang pagpapatupad ng mga pinakamahuhusay na kagawian na ito ngayon at tuklasin kung paano maaaring i-streamline ng AdsPower at IPOasis proxy ang iyong mga pagsisikap.

Binabasa din ng mga tao

- 7 Pinakamahusay na Kagamitan para sa Paglutas ng Captcha noong 2026 Kung Ihahambing (Mga Kalamangan at Kahinaan)

7 Pinakamahusay na Kagamitan para sa Paglutas ng Captcha noong 2026 Kung Ihahambing (Mga Kalamangan at Kahinaan)

Mga tagalutas ng CAPTCHA noong 2026 na inihambing para sa web scraping, bilis, katumpakan at presyo. Hanapin ang pinakamahusay na tool para sa mga hamon ng reCAPTCHA at Cloudflare.

- Awtomasyon sa Paglutas ng CAPTCHA: Isang Paghahambing ng mga Serbisyo sa Paglutas ng CAPTCHA para sa mga Developer

Awtomasyon sa Paglutas ng CAPTCHA: Isang Paghahambing ng mga Serbisyo sa Paglutas ng CAPTCHA para sa mga Developer

Paghambingin ang mga nangungunang serbisyo sa paglutas ng CAPTCHA para sa automation. Suriin ang bilis, katumpakan, presyo, at mga API upang mapili ang pinakamahusay na solusyon sa paglutas ng CAPTCHA.

- Nangungunang 11 Serbisyo ng Proxy para sa Bilis, Pagkawala ng Pagkakakilanlan, at Kahusayan (Update sa 2026)

Nangungunang 11 Serbisyo ng Proxy para sa Bilis, Pagkawala ng Pagkakakilanlan, at Kahusayan (Update sa 2026)

Ang artikulong ito ay nagbibigay ng komprehensibong pagsusuri sa nangungunang 11 pinakamabilis na serbisyo ng proxy na magagamit sa 2026.

- Paano I-maximize ang Iyong CTR gamit ang AdsPower × Traffic Bot

Paano I-maximize ang Iyong CTR gamit ang AdsPower × Traffic Bot

I-maximize ang iyong CTR sa 2025 gamit ang AdsPower × Traffic Bot. Palakasin ang mga ranking sa SEO gamit ang ligtas, mala-tao na trapiko at advanced na anti-detect na fingerprint ng browser

- Kumita ng Malaki gamit ang AdsPower: Gumawa ng Mga Tutorial at Manalo ng Hanggang $400!

Kumita ng Malaki gamit ang AdsPower: Gumawa ng Mga Tutorial at Manalo ng Hanggang $400!

Kung ikaw ay isang tagalikha ng nilalaman, magkakaroon ka ng napakadaling pagkakataong kumita ng pera. Gumawa ng video o artikulo para sa AdsPower at manalo ng hanggang 400 dollars no