Hoe u proxy's kunt gebruiken voor webscraping zonder geblokkeerd te worden

Neem een snelle blik

Rationeel en effectief gebruik van proxy's helpt je webscraping zonder geblokkeerd te worden. Ontdek tips om anonimiteit te behouden en naadloos data te scrapen. Klaar om je scrapingproces te optimaliseren? Bekijk onze gids en begin vandaag nog slimmer te scrapen!

Webscraping is een techniek die wordt gebruikt om gegevens van webpagina's te extraheren. Het werkt door verzoeken naar doelwebsites te sturen, net zoals een browser dat doet. Dit maakt het mogelijk om verschillende informatie op te halen, zoals tekst, afbeeldingen en links.

Webscraping kent verschillende toepassingen:

-

E-commerce: Vergemakkelijkt prijsbewaking, waardoor bedrijven en consumenten betere aankoopbeslissingen kunnen nemen en concurrerende prijzen kunnen vaststellen.

-

Nieuws: Maakt aggregatie van verschillende bronnen mogelijk, waardoor een uitgebreid nieuwsoverzicht op één platform ontstaat.

-

Leadgeneratie: Helpt bedrijven bij het vinden van potentiële klanten door relevante gegevens te extraheren en marketing te verbeteren Effectiviteit.

-

SEO: Wordt gebruikt voor het monitoren van pagina's met zoekresultaten en het optimaliseren van websitecontent en -strategieën.

-

Financiën: In applicaties zoals Mint (VS) en Bankin' (Europa) maakt het het samenvoegen van bankrekeningen mogelijk voor gestroomlijnd beheer van persoonlijke financiën.

-

Onderzoek: Helpt individuen en onderzoekers datasets te creëren die anders ontoegankelijk zouden zijn, ter bevordering van academisch onderzoek en datagestuurde projecten.

Maar velen zijn het zat dat webscrapingprojecten worden geblokkeerd of op een zwarte lijst worden gezet. Sterker nog, het volgen van zoveel mogelijk best practices is alles wat nodig is om een mislukt webdata-extractieproces te voorkomen.

De truc om succesvol webscraping uit te voeren is om te voorkomen dat je als een robot wordt behandeld en de anti-botsystemen van de site omzeilt. Dit komt doordat de overgrote meerderheid van de websites datascraping niet accepteert en zich inspant om het proces te blokkeren.

Dit bericht helpt je inzicht te krijgen in de verschillende soorten informatie die websites gebruiken om te voorkomen dat informatie wordt gecrawld, en welke strategieën je kunt implementeren om deze anti-botbarrières succesvol te overwinnen.

Kies de juiste proxyservers

Websites detecteren webscrapers voornamelijk door hun IP-adressen te controleren en te volgen hoe ze zich gedragen.

Als de server vreemd gedrag of een onwaarschijnlijke frequentie van verzoeken, enz. van een gebruiker detecteert, blokkeert de server dat IP-adres zodat het de site niet meer kan bezoeken.

Dit is waar het gebruik van een proxyserver komt om de hoek kijken. Met proxyservers kunt u verschillende IP-adressen gebruiken, zodat het lijkt alsof uw verzoeken van over de hele wereld komen. Dit helpt detectie en blokkering te voorkomen.

Om te voorkomen dat alle verzoeken vanaf hetzelfde IP-adres worden verzonden, raden we u aan een IP-rotatieservice te gebruiken. Deze verbergt het echte IP-adres tijdens het crawlen van de gegevens.

Om de slagingskans te vergroten, is het ook belangrijk de juiste proxy te kiezen. Voor geavanceerdere sites met anti-crawlmechanismen zijn residentiële proxyservers bijvoorbeeld geschikter.

Het is belangrijk om te weten dat de kwaliteit van uw proxyserver een grote invloed kan hebben op het succes van uw datacrawl. Het is daarom de moeite waard om te investeren in een goede proxyserver.

De proxyservers van IPOasis kunnen bedrijven helpen bij het uitvoeren van webscraping zonder detectie of blokkering. Hun proxy's omzeilen geografische beperkingen, wisselen IP-adressen uit en voeren scraping op schaal uit zonder de normale werking van de doelwebsite te verstoren.

Met meer dan 80 miljoen echte residentiële IP-adressen uit 195 landen bieden de proxy's van IPOasis de flexibiliteit en schaalbaarheid die nodig zijn voor elk webscrapingproject. U hoeft zich nooit meer zorgen te maken dat u geblokkeerd wordt tijdens het verzamelen van openbare webdata.

Bovendien werken de proxy's van IPOasis op piekmomenten en grote schaal, waardoor klanten altijd de proxy's hebben die ze nodig hebben. Voorkom dat u wordt geblokkeerd door onbeperkte sessies te gebruiken en IP-locaties zo vaak als nodig te wijzigen. Vertrouw op de betrouwbaarheid en effectiviteit van scrapingproxy's voor dataverzameling.

Beheer verzoekfrequenties

-

Vertraging van verzoeken: Omdat u het gedrag van normale gebruikers moet nabootsen, vermijdt u het verzenden van een groot aantal verzoeken in een zeer korte periode. Geen enkele echte gebruiker bladert op deze manier door een website en dit gedrag is gemakkelijk te detecteren door anti-crawlingtechnieken. Als menselijke gebruikers bijvoorbeeld doorgaans een paar seconden wachten tussen het laden van pagina's, moet u de verzoeken dienovereenkomstig spreiden. Een goede vuistregel is om het aantal verzoeken per minuut te beperken, afhankelijk van de aard van de site.

-

Randomiseer het verzoekinterval: introduceer willekeurige vertragingen tussen verzoeken, variërend van een paar seconden tot een paar minuten om de willekeur te vergroten en detectie te voorkomen. Dit zorgt ervoor dat uw verkeerspatronen meer lijken op die van echte gebruikers, die mogelijk verschillende hoeveelheden tijd tussen acties op de site doorbrengen. U kunt een programmeerfunctie gebruiken om willekeurige getallen binnen een bereik te genereren om de tijdsvertraging tussen verzoeken in te stellen.

Stel de juiste headers in

-

User-Agent String: De User-Agent header vertelt de site welke browser en welk besturingssysteem de gebruiker gebruikt. Een manier om deze strategie flexibel toe te passen om uw verzoeken te laten lijken alsof ze afkomstig zijn van verschillende browsers en apparaten, is door meerdere User-Agent strings te gebruiken. U kunt bijvoorbeeld de User-Agent-strings roteren voor Chrome op Windows, Firefox op Mac en Safari op iOS.

-

De Referrer Header: De Referrer Header is een onderdeel van de HTTP-header. Deze wordt gebruikt om de webpagina te identificeren van waaruit een verzoek wordt geïnitieerd. Simpel gezegd: wanneer een browser van de ene webpagina naar de andere navigeert, wordt deze gebruikt om de webpagina te identificeren van waaruit het verzoek is geïnitieerd. Als een browser van de ene webpagina (de bronpagina) naar een andere webpagina (de bestemmingspagina) navigeert en een verzoek verzendt, vertelt de Referrer Header de bestemmingspagina waar het verzoek vandaan kwam. Het instellen van een geldige Referrer kan uw verzoeken legitiemer laten lijken. Als u op een e-commercesite naar een productpagina zoekt, kunt u de Referrer zo instellen dat deze linkt naar de categoriepagina van de productpagina. Deze strategieën helpen uw crawlactiviteit te maskeren en zorgen voor meer menselijke interactie met de site, waardoor de kans op het activeren van anti-botverdedigingssystemen wordt geminimaliseerd.

Gebruik een Headless Browser

Een headless browser is een krachtige tool voor webscraping zonder anti-botsystemen te activeren. In tegenstelling tot standaard webscrapingbibliotheken repliceren headless browsers zoals Puppeteer of Selenium het menselijke browsen door volledige webpagina's te laden, inclusief JavaScript en dynamische content.

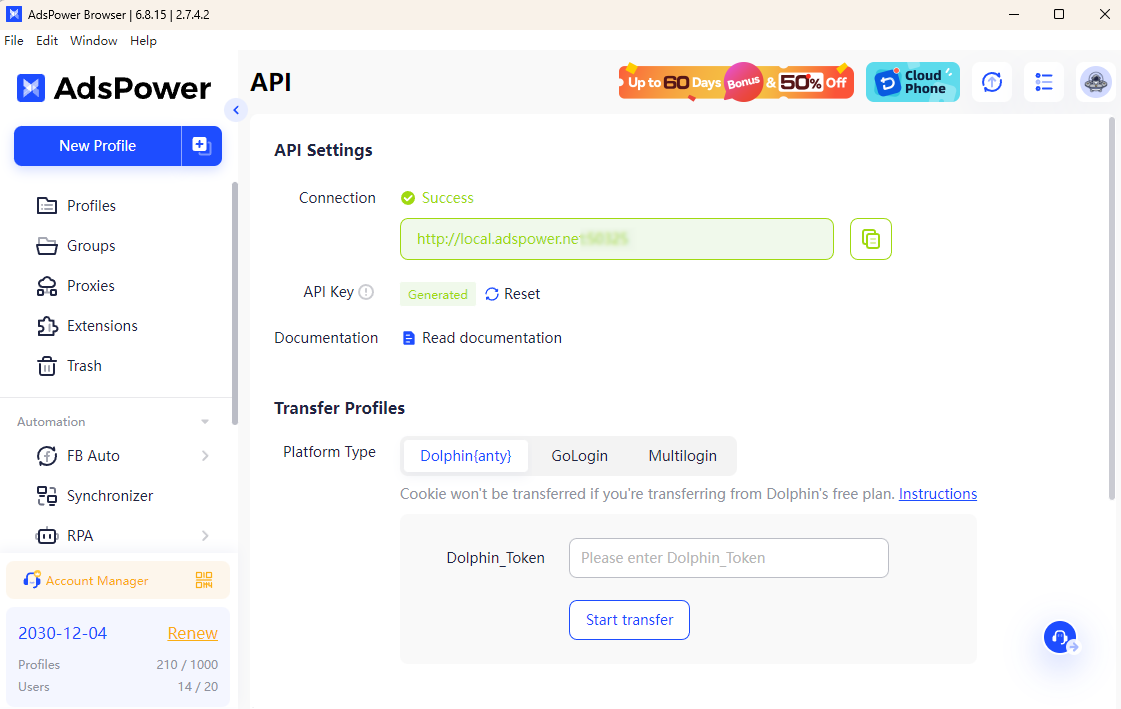

In combinatie met de AdsPower-browser wordt uw scrapingproces nog efficiënter. Met AdsPower kunt u de headless-modus starten met een headless-modus en API-sleutel. met een headless-modus en API-sleutel. Hiermee kunt u unieke browserfingerprints configureren en proxyservers naadloos integreren, waardoor het voor websites moeilijker wordt om geautomatiseerde activiteit te detecteren. Deze combinatie zorgt voor meer anonimiteit en verkleint het risico op blokkering.

Met AdsPower kunt u authentiek surfgedrag simuleren terwijl u moeiteloos IP-adressen wisselt en meerdere accounts beheert. Dit zorgt voor soepel scrapen, zelfs op sites met strenge anti-crawlingmechanismen, waardoor uw webscrapingprojecten relatief succesvol en veilig zijn.

Met de bovenstaande praktische manieren kunt u websitegegevens scrapen zonder geblokkeerd te worden. Klaar om uw webscrapingstrategie te verbeteren? Begin vandaag nog met het implementeren van deze best practices en ontdek hoe AdsPower en IPOasis-proxy uw inspanningen kunnen stroomlijnen.

Mensen lezen ook

- De 7 beste tools voor het oplossen van captcha's in 2026 vergeleken (voor- en nadelen)

De 7 beste tools voor het oplossen van captcha's in 2026 vergeleken (voor- en nadelen)

CAPTCHA-oplossers van 2026 vergeleken op basis van webscraping, snelheid, nauwkeurigheid en prijs. Vind de beste tool voor reCAPTCHA- en Cloudflare-uitdagingen.

- Automatische CAPTCHA-oplossing: een vergelijking van CAPTCHA-oplossingsservices voor ontwikkelaars

Automatische CAPTCHA-oplossing: een vergelijking van CAPTCHA-oplossingsservices voor ontwikkelaars

Vergelijk toonaangevende CAPTCHA-oplossingsdiensten voor automatisering. Bekijk snelheid, nauwkeurigheid, prijs en API's om de beste CAPTCHA-oplossing te kiezen.

- De 11 beste proxydiensten voor snelheid, anonimiteit en efficiëntie (update 2026)

De 11 beste proxydiensten voor snelheid, anonimiteit en efficiëntie (update 2026)

Dit artikel biedt een uitgebreid overzicht van de 11 snelste proxydiensten die in 2026 beschikbaar zijn.

- Hoe werkt het huren van een Facebook-advertentieaccount: een praktische gids voor groeiende adverteerders

Hoe werkt het huren van een Facebook-advertentieaccount: een praktische gids voor groeiende adverteerders

Deze handleiding legt uit hoe je een Facebook-advertentieaccount huurt en hoe je veilig kunt schalen met Meta-whitelisted accounts met behulp van GDT Agency en AdsPower.

- Hoe u uw CTR kunt maximaliseren met AdsPower × Traffic Bot

Hoe u uw CTR kunt maximaliseren met AdsPower × Traffic Bot

Maximaliseer uw CTR in 2025 met AdsPower × Traffic Bot. Verbeter uw SEO-ranking met veilig, mensgericht verkeer en geavanceerde anti-browser fingerprint.