Jak korzystać z serwerów proxy do scrapowania stron internetowych bez blokowania

Rzuć okiem

Rozsądne i efektywne korzystanie z serwerów proxy pomoże Ci scrapować dane z internetu bez ryzyka zablokowania. Poznaj wskazówki, jak zachować anonimowość i bezproblemowo scrapować dane. Gotowy na optymalizację procesu scrapowania? Zapoznaj się z naszym przewodnikiem i zacznij scrapować mądrzej już dziś!

Web Scraping to technika służąca do ekstrakcji danych ze stron internetowych. Działa poprzez wysyłanie żądań do stron docelowych, podobnie jak robi to przeglądarka. Umożliwia to pobieranie różnych informacji, takich jak tekst, obrazy i linki.

Scraping z sieci ma kilka zastosowań:

-

E-commerce: Ułatwia monitorowanie cen, pomagając firmom i konsumentom podejmować lepsze decyzje zakupowe i ustalać konkurencyjne ceny.

-

Wiadomości: Umożliwia agregację z różnych źródeł, zapewniając kompleksowy przegląd wiadomości na jednej platformie.

-

Generowanie leadów: Pomaga firmom w znajdowaniu potencjalnych klientów poprzez ekstrakcję odpowiednich danych i zwiększanie skuteczności marketingu.

-

SEO: Służy do monitorowania stron wyników wyszukiwania oraz optymalizacji treści i strategii witryn.

-

Finanse: W aplikacjach takich jak Mint (USA) i Bankin' (Europa) umożliwia agregację kont bankowych w celu usprawnienia zarządzania finansami osobistymi.

-

Badania: Pomaga osobom fizycznym i badaczom tworzyć zbiory danych, które są w inny sposób niedostępne, promując badania naukowe i oparte na danych projektów.

Wielu ma już dość blokowania lub umieszczania projektów web scrapingu na czarnej liście. W rzeczywistości, aby uniknąć nieudanego procesu ekstrakcji danych z sieci, wystarczy stosować się do jak największej liczby dobrych praktyk.

Sztuczka skutecznego web scrapingu polega na tym, aby uniknąć traktowania jak robota i ominięcia systemów antybotowych witryny. Dzieje się tak, ponieważ zdecydowana większość stron internetowych nie akceptuje scrapowania danych i będzie podejmować wysiłki, aby zablokować ten proces.

Ten post pomoże Ci zrozumieć różne informacje wykorzystywane przez strony internetowe do zapobiegania indeksowaniu informacji oraz strategie, które możesz wdrożyć, aby skutecznie pokonać te bariery antybotowe.

Wybierz odpowiednie serwery proxy

Strony internetowe wykrywają scrapery internetowe przede wszystkim poprzez sprawdzanie ich adresów IP i śledzenie ich zachowania.

Jeśli serwer wykryje nietypowe zachowanie lub nietypową częstotliwość żądań itp. od użytkownika, blokuje dostęp tego adresu IP do witryny.

Właśnie tutaj Wchodzi na scenę serwer proxy. Serwery proxy umożliwiają korzystanie z różnych adresów IP, aby sprawiać wrażenie, że Twoje żądania pochodzą z całego świata. Pomaga to uniknąć wykrycia i zablokowania.

Aby uniknąć wysyłania wszystkich żądań z tego samego adresu IP, zaleca się skorzystanie z usługi rotacji adresów IP, która ukrywa prawdziwy adres IP podczas indeksowania danych.

Ponadto, aby zwiększyć skuteczność, należy wybrać odpowiedni serwer proxy. Na przykład w przypadku bardziej zaawansowanych witryn z mechanizmami anty-crawl bardziej odpowiednie są serwery proxy.

Warto zauważyć, że jakość serwera proxy może znacząco wpłynąć na skuteczność indeksowania danych, dlatego warto zainwestować w dobry serwer proxy.

Serwery proxy IPOasis mogą pomóc firmom w scrapowaniu stron internetowych bez wykrycia lub zablokowania. Ich serwery proxy pokonują ograniczenia geograficzne, zmieniają adresy IP i wykonują scraping na dużą skalę, nie zakłócając normalnego działania witryny docelowej.

Dzięki ponad 80 milionom rzeczywistych adresów IP ze 195 krajów, serwery proxy IPOasis do scrapingu zapewniają elastyczność i skalowalność niezbędną w każdym projekcie scrapingu internetowego. Nigdy więcej nie będziesz musiał martwić się o zablokowanie podczas gromadzenia publicznych danych internetowych.

Dodatkowo, serwery proxy IPOasis działają w godzinach szczytu i na dużą skalę, zapewniając klientom zawsze dostęp do potrzebnych im serwerów proxy. Unikaj flagowania, korzystając z nieograniczonej liczby sesji i zmieniając lokalizacje IP tak często, jak to konieczne. Zaufaj niezawodności i skuteczności serwerów proxy do scrapowania danych.

Zarządzaj liczbą żądań

-

Spowolnij żądania: Ponieważ musisz naśladować zachowanie zwykłych użytkowników, unikaj wysyłania dużej liczby żądań w bardzo krótkim czasie. Żaden prawdziwy użytkownik nie przegląda witryny w ten sposób, a takie zachowanie jest łatwo wykrywane przez techniki antycrawlingowe. Na przykład, jeśli użytkownicy zazwyczaj czekają kilka sekund między załadowaniami stron, należy odpowiednio rozłożyć żądania. Dobrą zasadą jest ograniczenie liczby żądań na minutę w zależności od charakteru witryny.

-

Losuj interwał żądań: wprowadź losowe opóźnienia między żądaniami, od kilku sekund do kilku minut, aby zwiększyć losowość i uniknąć wykrycia. Dzięki temu wzorce ruchu będą bardziej przypominać wzorce rzeczywistych użytkowników, którzy mogą spędzać różne ilości czasu między kolejnymi działaniami w witrynie. Możesz użyć funkcji programistycznej do generowania liczb losowych w określonym zakresie, aby ustawić opóźnienie czasowe między żądaniami.

Ustaw odpowiednie nagłówki

-

Ciąg User-Agent: Nagłówek User-Agent informuje witrynę, do której przeglądarki i systemu operacyjnego uzyskuje dostęp użytkownik. Jednym ze sposobów elastycznego zastosowania tej strategii, aby żądania wyglądały na pochodzące z różnych przeglądarek i urządzeń, jest użycie wielu ciągów User-Agent. Na przykład, można rotować ciągi User-Agent dla Chrome w systemie Windows, Firefox na Macu i Safari na iOS.

-

Nagłówek Referrer: Nagłówek Referrer jest częścią nagłówka HTTP. Służy do identyfikacji strony internetowej, z której zainicjowano żądanie. Mówiąc prościej, gdy przeglądarka przechodzi z jednej strony internetowej na drugą, służy ona do identyfikacji strony internetowej, z której zainicjowano żądanie. Przeglądarka przechodzi z jednej strony internetowej (strony źródłowej) na inną stronę internetową (stronę docelową) i wysyła żądanie. Nagłówek Referrer informuje stronę docelową, skąd pochodzi żądanie. Ustawienie prawidłowego Referrer może sprawić, że Twoje żądania będą wyglądać bardziej wiarygodnie. Jeśli szukasz strony produktu w witrynie e-commerce, możesz ustawić Referrer tak, aby linkował do strony kategorii produktu. Strategie te pomagają maskować aktywność indeksowania i zwiększyć interakcję użytkownika z witryną, minimalizując w ten sposób ryzyko uruchomienia zabezpieczeń antybotowych.

Użyj przeglądarki bez interfejsu graficznego

Przeglądarka bez interfejsu graficznego to potężne narzędzie do scrapowania stron internetowych bez uruchamiania systemów antybotowych. W przeciwieństwie do standardowych bibliotek do scrapowania stron internetowych, przeglądarki headless, takie jak Puppeteer czy Selenium, naśladują przeglądanie stron przez człowieka, ładując kompletne strony internetowe, w tym JavaScript i dynamiczną treść.

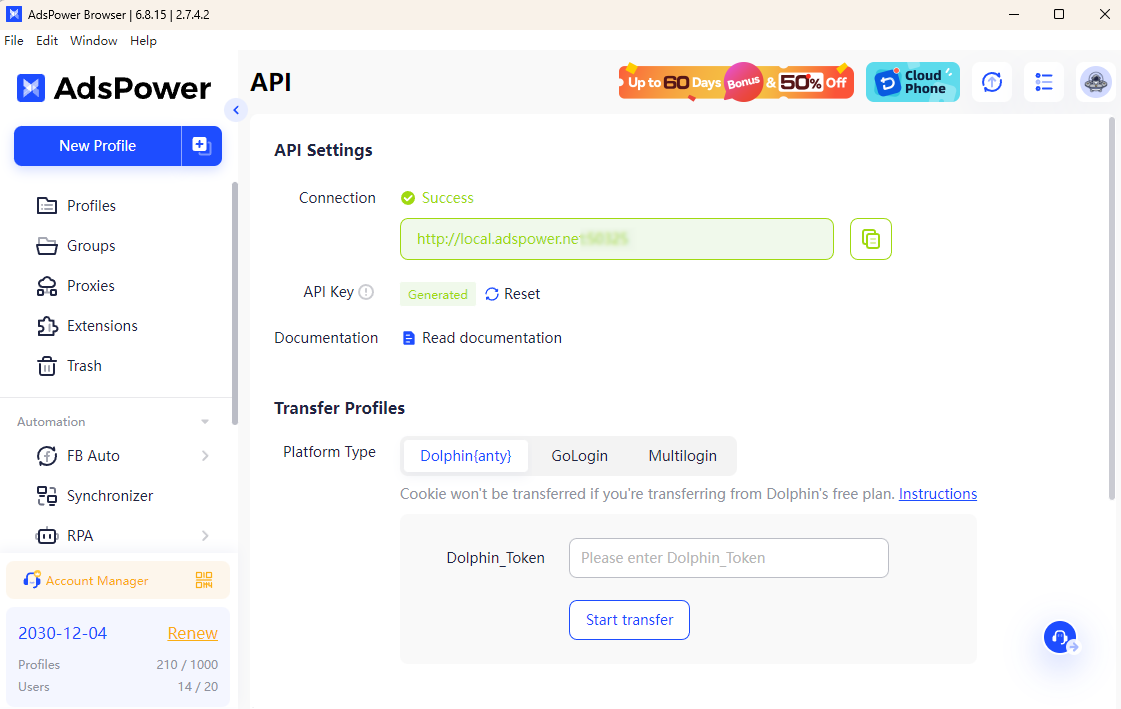

W połączeniu z przeglądarką AdsPower, proces scrapowania staje się jeszcze bardziej wydajny. AdsPower umożliwia uruchomienie trybu headlessz headless i kluczem API. Dzięki temu możesz skonfigurować unikalne odciski palców przeglądarki i bezproblemowo zintegrować serwery proxy, utrudniając stronom internetowym wykrywanie zautomatyzowanej aktywności. Ta kombinacja zapewnia zwiększoną anonimowość i zmniejsza ryzyko zablokowania.

Dzięki AdsPower możesz symulować autentyczne zachowania przeglądania, jednocześnie zmieniając adresy IP i zarządzając wieloma kontami bez wysiłku. Zapewnia to płynne scrapowanie, nawet w witrynach ze ścisłymi mechanizmami antycrawlingowymi, dzięki czemu Twoje projekty scrapowania stron internetowych są stosunkowo skuteczne i bezpieczne.

Dzięki powyższym praktycznym metodom możesz scrapować dane ze stron internetowych bez ryzyka zablokowania. Gotowy, aby ulepszyć swoją strategię scrapowania stron internetowych? Zacznij wdrażać te najlepsze praktyki już dziś i przekonaj się, jak AdsPower i proxy IPOasis mogą usprawnić Twoje działania.

Ludzie czytają także

- Porównanie 7 najlepszych narzędzi do rozwiązywania captcha w 2026 roku (zalety i wady)

Porównanie 7 najlepszych narzędzi do rozwiązywania captcha w 2026 roku (zalety i wady)

Porównanie narzędzi CAPTCHA 2026 pod kątem scrapowania stron internetowych, szybkości, dokładności i cen. Znajdź najlepsze narzędzie do rozwiązywania problemów reCAPTCHA i Cloudflare.

- Automatyzacja rozwiązywania CAPTCHA: Porównanie usług rozwiązywania CAPTCHA dla programistów

Automatyzacja rozwiązywania CAPTCHA: Porównanie usług rozwiązywania CAPTCHA dla programistów

Porównaj wiodące usługi rozwiązywania CAPTCHA do automatyzacji. Sprawdź szybkość, dokładność, ceny i interfejsy API, aby wybrać najlepsze rozwiązanie do rozwiązywania CAPTCHA.

- 11 najlepszych usług proxy pod względem szybkości, anonimowości i wydajności (aktualizacja z 2026 r.)

11 najlepszych usług proxy pod względem szybkości, anonimowości i wydajności (aktualizacja z 2026 r.)

W artykule tym znajdziesz kompleksowy przegląd 11 najszybszych usług proxy dostępnych w 2026 roku.

- Jak działa wynajem kont reklamowych na Facebooku: praktyczny przewodnik dla rozwijających się reklamodawców

Jak działa wynajem kont reklamowych na Facebooku: praktyczny przewodnik dla rozwijających się reklamodawców

W tym przewodniku znajdziesz informacje na temat wynajmu kont reklamowych na Facebooku oraz bezpiecznego skalowania za pomocą kont umieszczonych na białej liście Meta przy użyciu GDT Agency i AdsPower.

- Jak zmaksymalizować współczynnik klikalności (CTR) dzięki AdsPower × Traffic Bot

Jak zmaksymalizować współczynnik klikalności (CTR) dzięki AdsPower × Traffic Bot

Zmaksymalizuj swój CTR w 2025 roku dzięki AdsPower × Traffic Bot. Popraw pozycję w wynikach wyszukiwania dzięki bezpiecznemu, realistycznemu ruchowi i zaawansowanemu odciskowi palca przeglądarki, który zapobiega wykrywaniu.