Как парсить информацию на веб-страницах: инструкция для начинающих

Каждый день мы сталкиваемся с различными формами данных. Данные, которые мы анализируем, понимаем и иногда даже собираем. Эти три ключевых способа взаимодействия с данными являются основой аналитики информации. В современном цифровом мире аналитика данных быстро превратилась в неотъемлемую часть многих бизнесов, многие из которых используют веб-парсинг, искусственный интеллект, машинное обучение и целый ряд других инструментов и технологий для получения уникальных инсайтов в надежде прокачать свой бизнес.

В данной статье мы рассмотрим одну из многих техник, которую использует бизнес для сбора данных с веб-страниц в интернете — технику парсинга. Мы постараемся объяснить, что это такое и почему это важно, а также рассмотрим последствия этой деятельности и проанализируем в деталях суть работы.

Поехали!

Что такое парсинг веб-страниц?

Если вы когда-либо выделяли мышью данные с веб-сайта и копировали их в Excel, то поздравляю! Вы практиковали веб-парсинг, правда в небольшом масштабе.

Веб-парсинг, или сбор данных, - это метод сбора информации из интернета с использованием специальных программ или ботов.

Веб-парсеры работают полностью автоматически, переходя по страницам сайтов и извлекая нужную для вас информацию.

Применение веб-парсинга отличается от ручного копирования данных в Excel. Веб-парсинг автоматизирован, и может скопировать миллионы едениц данных за считанные минуты. Эти данные могут быть сохранены в офлайн-хранилище или в определенный файл в выбранном формате.

Законен ли парсинг веб-страниц?

Прежде чем мы погрузимся в статью, давайте обсудим насущный вопрос: является ли законным копирование информации с кого-то сайта? Разрешен ли веб-парсинг? Не нарушает ли это авторские права? Ну, не совсем.

Веб-парсинг не связан со взломом. Это всего лишь копирование информации, уже доступной для общественности, информации, которую люди могут прочитать, но в более удобном для машины формате. Так что да, это законно. Но есть некие подводные камни.

Хотя парсинг веб-страниц законен, есть ограничения на виды информации, которые можно парсить, и на способы выполнения этой процедуры. В целом, нужно избегать персональных данных и перегрузок сервера. Ваш основной упор должен быть на получение общедоступной информации.

Чтобы лучше понять это, давайте рассмотрим пример: совершенно законно фотографировать на телефон, но съемка секретных мест или конфиденциальных документов может привести к серьезным правовым последствиям.

Типы веб-парсеров

Теперь давайте рассмотрим различные типы парсеров. Веб-парсеры могут быть классифицированы на основе различных критериев, включая их происхождение, структуру и вариант использования. Давайте разберем эти классификации:

1. Самописные и готовые веб-парсеры

- Самописные веб-парсеры - это парсеры, которые создают опытные программисты с использованием Python и других языков программирования.

- Готовые веб-парсеры, в отличие от самописных, уже сделаны кем-то и доступны для использования. Они часто оснащены широким спектром опций и подходят для потребностей новичков.

2. Браузерные расширения и ПО для парсеров

- Расширения для парсеров интегрированы в браузерах и легко запускаются. Однако они часто ограничены возможностями и способностями браузера. Этот тип веб-парсеров обычно функционирует еще лучше на антидетект браузерах, но об этом позже.

- Программные веб-парсеры можно скачать и установить на компьютер. Они более сложны в использовании, чем расширения в браузере, но вместе с этим предлагают расширенные функции почти без ограничений, связанных с возможностями браузера.

3. Облачные парсеры против локальных

- Облачные парсеры работают на удаленных серверах, которые предоставляем компания парсера. Это позволяет распределить нагрузку с вашего компьютера и выполнять весь процесс парсинга без ограничений аппаратных возможностей вашего компьютера.

- Локальные парсеры работают на вашем компьютере и используют программное обеспечение и аппаратные возможности вашего компьютера.

Различные виды парсеров имеют свои преимущества и недостатки в зависимости от ваших потребностей. В конце концов, когда вы готовы начать парсинг, всегда найдется подходящий вариант, который будет соответствовать вашим потребностям и уровню вашего профессионализма.

Для чего используется веб-парсинг?

Теперь, когда мы понимаем, что такое веб-парсинг и для чего он используется. Если анализ данных имеет значение, то собирание данных также важно, что означает суть веб-парсинга. Сбор данных является неотъемлемой частью многих бизнесов, поэтому, в любой нише всегда можно найти применение для извлечения данных и, следовательно, для веб-парсинга. Итак, вот три ниши для применения парсинга:

1. Парсинг веб-страниц в розничной торговле и электронной коммерции

В нише розничной торговли и электронной коммерции, где конкуренция ожесточенная, сбор данных является важной стратегией, веб-парсинг проявляет свои преимущества. Если вы хотите оставаться впереди конкурентов, вам постоянно нужен доступ к правильным данным, и именно это позволяет веб-парсинг.

Веб-парсинг обеспечивает более глубокое понимание стратегий, которые используют ваши конкуренты для увеличения своего онлайн-трафика. Если бы вы смогли получить доступ к данным своих конкурентов через веб-парсинг, вы могли бы вносить коррективы в свои собственные маркетинговые стратегии, в конечном итоге повышая количество продаж. Провайдеры услуг, такие как Scrape Yogi, предоставляют услуги по парсингу для брендов электронной коммерции.

2. Парсинг веб-страниц в сфере финансов и финансовых технологий

В области финансов и фондового рынка, веб-парсинг может быть полезным инструментом, который помогает собирать данные о ценных бумагах в реальном времени, финансовых отчетах и информацию о том, как некоторые финансовые компании ведут свой бизнес. Эта информация особенно важна при принятии инвестиционных решений и планировании.

Кроме того, многие участники финансового рынка используют веб-парсинг чтобы получить представление о финансовом мире. Это позволяет им приобрести четкое представление о финансовом мире, обеспечивая быстрое и умное принятие решений.

3. Парсинг веб-страниц в Digital маркетинге и SEO

Веб-парсинг широко используется в индустрии цифрового маркетинга для сбора ценных данных о предпочтениях клиентов, онлайн-поведении пользователей, актуальных темах и стратегиях конкурентов.

Используя техники веб-парсинга, если вы Digital маркетолог, вы получаете ценные инсайды, которые помогают точнее настраивать вашу стратегию. Это обеспечивает ваше лидерство в мире постоянно изменяющихся онлайн-трендов потребительского поведения.

Инструменты, которые вам понадобятся для парсинга

В зависимости от типа страниц парсинга, который вы хотите сделать, вам понадобятся три основных инструмента:

1. Антидетект браузер

Антидетект браузеры используют передовые технологии подмены данных, чтобы защитить конфиденциальность интернет-пользователей. Некоторые современные антидетект браузеры, такие как лидер отрасли AdsPower, также предлагают управление несколькими браузерными профилями. Вы можете узнать все про антидетект браузеры в этой подробной статье.

Зачем вам нужен антидетект браузер для веб-парсинга? Многие сайты используют различные технологии отслеживание, включая файлы cookie, цифровые отпечатки и веб-маячки, чтобы собирать информацию о своих посетителях. Поэтому, в процессе парсинга, сам сайт может собирать информацию о вас. Именно поэтому вам нужен анонимный браузер.

Если вы ищете анонимный браузер, который сочетает в себе эффективность и доступность, то AdsPower - лучший выбор.

2. Python

Python, возможно, самый важный язык программирования для изучения, если вы пытаетесь стать экспертом во многих различных типах извлечения данных и веб-парсинга. Он универсален, надежен и хорошо подходит для потребностей как начинающих, так и экспертов. Кроме того, многие из наиболее популярных библиотек для веб-парсинга созданы на Python.

Чтобы узнать больше о Python для веб-парсинга, посетите эту страницу.

3. Библиотеки парсинга веб-страниц

Эти библиотеки действуют как надежные платформы, упрощающие извлечение данных с веб-сайтов. Есть четыре популярные библиотеки:

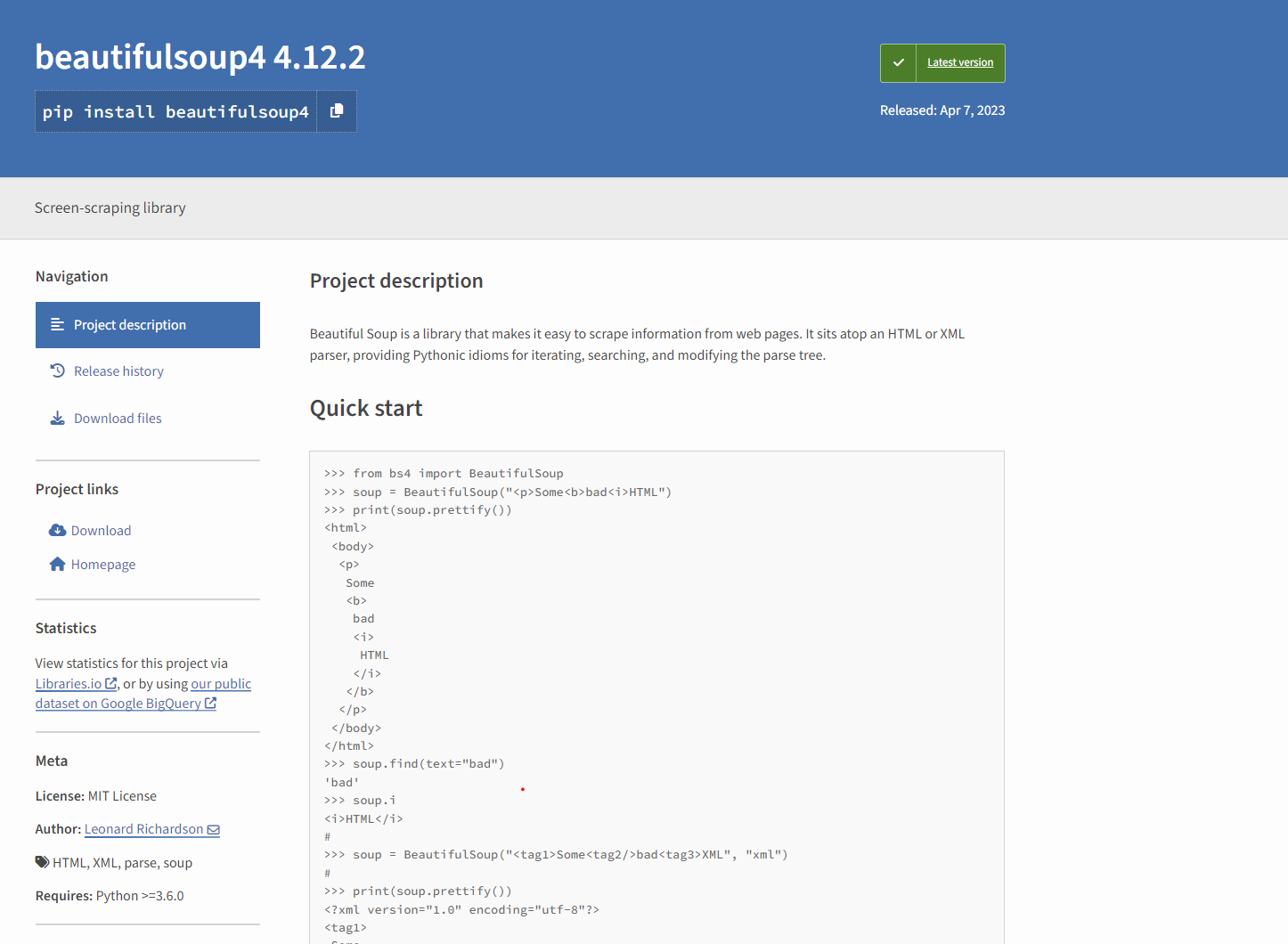

Beautiful Soup

Beautiful Soup — это библиотека Python, которая специализируется на извлечении данных из файлов HTML и XML. Он предоставляет идиомы Pythonic для итерации, поиска и изменения дерева синтаксического анализа, что делает его фаворитом среди веб-парсеров благодаря его простоте и универсальности. Beautiful Soup идеально подходит для анализа документов HTML и XML, навигации по дереву синтаксического анализа и извлечения соответствующей информации.

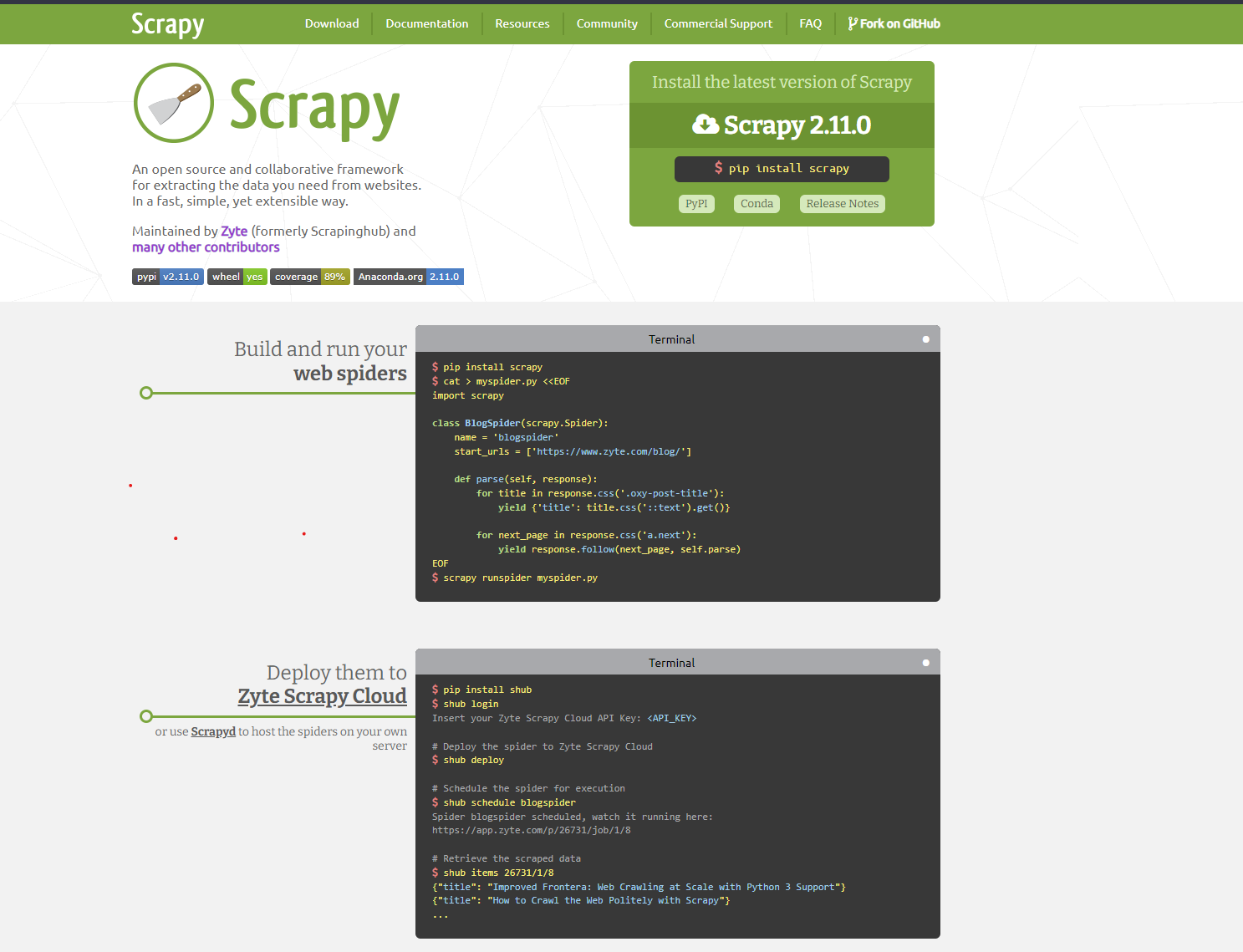

Scrapy

Scrapy — это платформа для совместного сканирования веб-страниц с открытым исходным кодом для Python, которая упрощает извлечение данных с веб-сайтов благодаря своим встроенным функциям. Scrapy идеально подходит для масштабных задач по парсингу и хорошо подходит для реально масштабных проектов.

Pandas

Pandas — еще одна мощная библиотека для обработки и анализа данных на Python. Хотя она и не является библиотекой очистки веб-страниц, она часто используется с другими библиотеками для эффективного манипулирования и анализа извлеченных данных. Он отлично подходит для очистки, преобразования и анализа данных после парсинга.

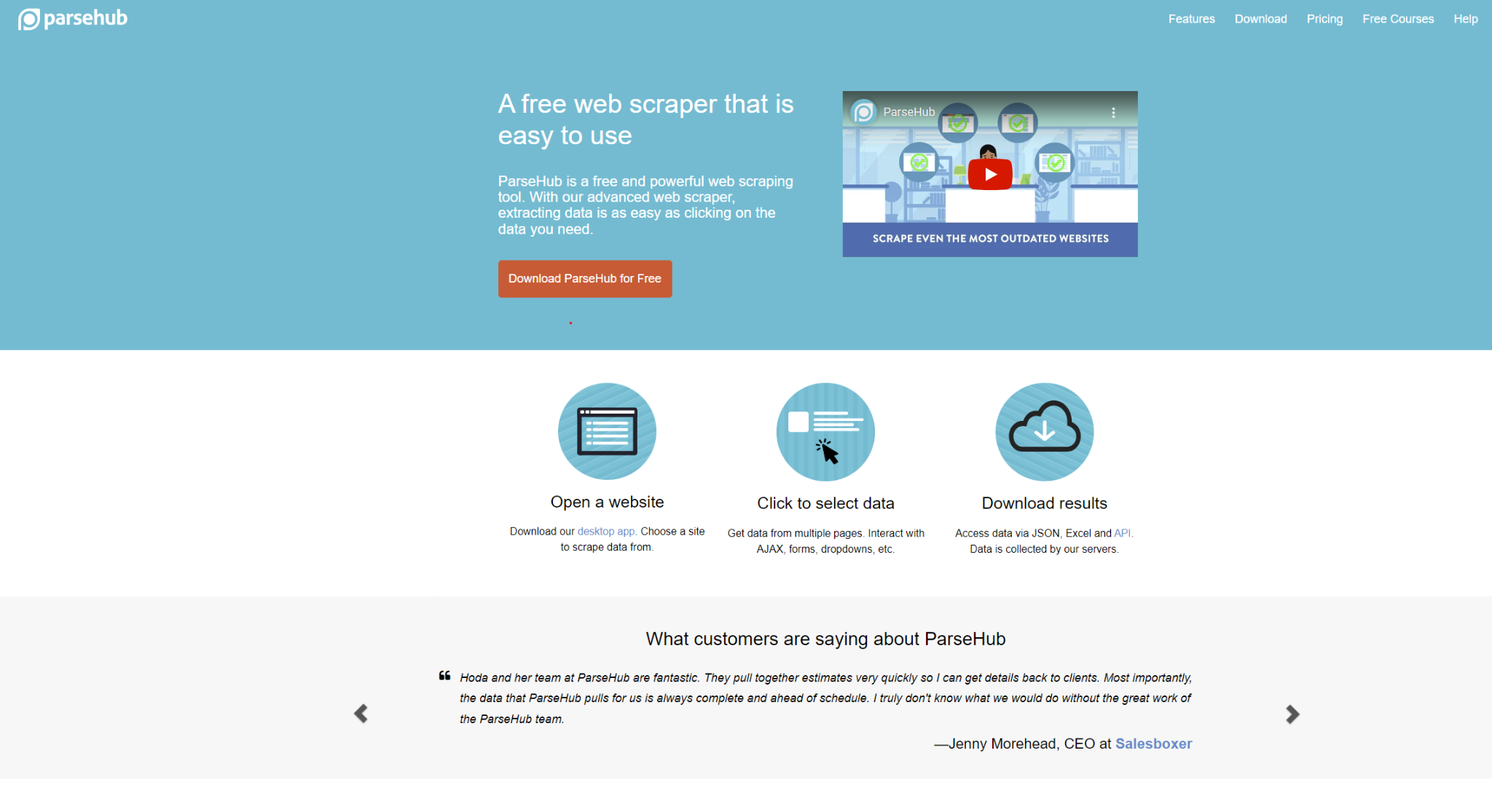

ParseHub

ParseHub выделяется как инструмент визуального извлечения данных, который упрощает парсинг веб-страниц с помощью подхода «покажи и кликни». Благодаря удобному интерфейсу он устраняет необходимость в обширных навыках программирования. Он особенно хорошо подходит для нужд пользователей, которые предпочитают визуальный интерфейс без глубоких знаний программирования.

Благодаря этим инструментам вы будете хорошо подготовлены к началу своего путешествия по парсингу веб-страниц.

How to Get Started with Web Scraping

Конкретный подход к этим шагам может варьироваться в зависимости от выбранных вами инструментов, но для простоты мы сосредоточимся на фундаментальных, нетехнических аспектах. Вот последовательные шаги, которые вам следует предпринять:

Определите URL-адреса для парсинга

Хотя это может показаться простым делом, первоначальная задача — определить веб-сайт, который вы хотите спарсить. Например, если вы сосредоточены на изучении отзывов клиентов о книгах, вы можете ориентироваться на соответствующие данные с таких платформ, как Amazon, Goodreads или LibraryThing.

Проанализируйте веб-страницу

Прежде чем писать код для парсера, важно понять, какую информацию он должен собирать. Клик правой кнопкой мыши в любом месте интерфейса веб-сайта открывает такие параметры, как «проверить элемент» или «просмотреть исходный код страницы». Это действие раскрывает базовый код сайта, который служит источником данных для парсера. Кстати, вы также можете использовать готовые решения парсеров.

Начинайте парсинг

Теперь, когда вы определили URL-адреса и проверили структуру веб-страниц, пришло время начать процесс парсинга. Это включает в себя реализацию необходимого кода или использование инструментов веб-парсинга для извлечения нужных данных с целевых сайтов. Конкретный метод выполнения этого шага может варьироваться в зависимости от выбранных инструментов, но основная цель остается той же: систематический сбор ценной информации из Интернета.

Итоги

С течением времени веб-парсинг значительно эволюционировал и стал очень важным аспектом анализа данных, и действительно, это очень полезно для бизнеса по всему миру. Он позволяет компаниям эффективно извлекать и анализировать огромные объемы информации из интернета. И по мере того, как технологии продолжают развиваться, роль веб-парсинг, скорее всего, будет расширяться. В ближайшем будущем веб-парсинг начнет предлагать еще более сложные и умные инструменты для цели извлекать богатство информации, доступной в интернете.

Эта статья - всего лишь один из многих бесплатных инструкций, доступных на сайте AdsPower. AdsPower предлагает разнообразный набор материалов, включая гайды и инструкции. Посетите наш сайт прямо сейчас, чтобы получить доступ к другому бесплатному, но не менее ценному контенту.

Люди также читают

- Мистер Бист: Самый богатый ютубер и его успешная стратегия заработка на YouTube в 2025 году

- Как заработать на Adsense? До 5000 руб. в день!

- Как заработать с Outlier AI и получать деньги за обратную связь для ИИ

- Как безопасно управлять несколькими аккаунтами агента Zillow в 2025 году

- Что делать, если Амазон заблокировал аккаунт