วิธีเริ่มต้นใช้งาน Web Scraping: คู่มือสำหรับผู้เริ่มต้น

ในแต่ละวัน เราพบเจอกับข้อมูลหลากหลายรูปแบบ ทั้งข้อมูลที่เราวิเคราะห์ ทำความเข้าใจ และบางครั้งถึงขั้นเก็บรวบรวมไว้ วิธีการหลักสามประการในการโต้ตอบกับข้อมูลเหล่านี้ถือเป็นรากฐานสำคัญของการวิเคราะห์ข้อมูล ในโลกดิจิทัลปัจจุบัน การวิเคราะห์ข้อมูลได้เติบโตอย่างรวดเร็วจนกลายเป็นส่วนสำคัญของธุรกิจมากมาย โดยหลายธุรกิจใช้การรวบรวมข้อมูลบนเว็บ (web scraping), AI, การเรียนรู้ของเครื่อง (machine learning) และเทคนิคและเทคโนโลยีอื่นๆ อีกมากมายเพื่อรวบรวมข้อมูลเชิงลึกเฉพาะตัว โดยหวังว่าจะช่วยพัฒนาธุรกิจของตน

อย่างไรก็ตาม ในบทความนี้ เราจะพิจารณาการรวบรวมข้อมูลบนเว็บ (web scraping) ซึ่งเป็นหนึ่งในเทคนิคมากมายที่ธุรกิจต่างๆ ใช้ในการรวบรวมข้อมูลจากเว็บไซต์บนอินเทอร์เน็ต เราจะอธิบายว่ามันคืออะไร เหตุใดจึงสำคัญ โดยคำนึงถึงผลทางกฎหมาย และเจาะลึกถึงวิธีการทำงานของมัน

มาเริ่มกันเลย!

Web Scraping คืออะไร

หากคุณเคยใช้เมาส์ไฮไลต์ส่วนรายละเอียดบางอย่างจากเว็บไซต์ด้วยตนเอง แล้วคัดลอกไปยังแผ่นงาน Excel ขอแสดงความยินดีด้วย! คุณเพิ่งฝึกการทำเว็บสเครปเปอร์ แม้ว่าจะอยู่ในระดับที่เล็กกว่ามากก็ตาม

การทำเว็บสเครปเปอร์ หรือบางครั้งเรียกกันว่าการทำข้อมูลสเครปเปอร์ เป็นเทคนิคการรวบรวมข้อมูลที่ใช้ในการรวบรวมเนื้อหาและข้อมูลจากอินเทอร์เน็ต โดยทั่วไปจะใช้เว็บสเครเปอร์ช่วย

หากคุณสงสัย เว็บสเครเปอร์โดยทั่วไปหมายถึงแอปพลิเคชันซอฟต์แวร์หรือบอทที่ถูกตั้งโปรแกรมให้นำทาง ดึงข้อมูลหน้าที่เกี่ยวข้อง และดึงข้อมูลที่มีค่าจากหน้าเว็บ

การใช้เว็บสเครเปอร์เป็นสิ่งที่ทำให้เว็บสเครปเปอร์แตกต่างจากการคัดลอกข้อมูลจากเว็บไซต์ไปยังเว็บไซต์ด้วยตนเอง แผ่นงาน Excel

การขูดเว็บเป็นระบบอัตโนมัติ และสามารถคัดลอกข้อมูลหลายล้านรายการโดยอัตโนมัติภายในไม่กี่นาที โดยปกติแล้ว "ข้อมูลหลายล้านรายการ" นี้จะอยู่ในเว็บเพจหนึ่งหรือหลายเว็บเพจก่อนจะถูกคอมไพล์ลงในพื้นที่จัดเก็บแบบออฟไลน์ที่คุณเลือก

การขูดเว็บถูกกฎหมายหรือไม่?

ก่อนที่จะเจาะลึกบทความนี้ เรามาพูดถึงประเด็นสำคัญที่หลายคนมองข้ามกันก่อน: การคัดลอกข้อมูลจากเว็บไซต์ของคนอื่นถูกกฎหมายหรือไม่? การขูดข้อมูลบนเว็บถูกกฎหมายหรือไม่? นั่นไม่ใช่การละเมิดลิขสิทธิ์ประเภทหนึ่งหรือ? ก็ไม่เชิง

การขูดข้อมูลบนเว็บไม่ใช่การแฮ็ก แต่มันเป็นเพียงการคัดลอกข้อมูลที่เปิดเผยต่อสาธารณะแล้ว ซึ่งมนุษย์สามารถอ่านได้ ให้เป็นรูปแบบที่เครื่องคอมพิวเตอร์สามารถอ่านได้ ดังนั้น ใช่แล้ว การขูดข้อมูลบนเว็บถูกกฎหมาย แต่มีเงื่อนไขอยู่อย่างหนึ่ง

แม้ว่าการรวบรวมข้อมูลบนเว็บจะถูกกฎหมาย แต่ก็มีข้อจำกัดเกี่ยวกับประเภทของข้อมูลที่คุณสามารถรวบรวมได้ และวิธีการรวบรวม โดยทั่วไปแล้ว คุณควรหลีกเลี่ยงข้อมูลส่วนบุคคลและภาระงานของเซิร์ฟเวอร์ คุณควรให้ความสำคัญกับข้อมูลที่เปิดเผยต่อสาธารณะเป็นหลัก

เพื่อให้เข้าใจแนวคิดนี้มากขึ้น ลองดูตัวอย่างนี้: แม้ว่าการถ่ายภาพด้วยโทรศัพท์ของคุณจะเป็นสิ่งที่ถูกกฎหมาย แต่การถ่ายภาพสถานที่สำคัญหรือเอกสารลับอาจส่งผลเสียทางกฎหมายได้

ประเภทของเว็บสเครเปอร์

ตอนนี้ ลองมาดูประเภทของเว็บสเครเปอร์ที่มีอยู่กัน เว็บสเครเปอร์สามารถจำแนกประเภทได้ตามเกณฑ์ต่างๆ รวมถึงแหล่งที่มา โครงสร้าง และสภาพแวดล้อมการทำงาน มาดูการจำแนกประเภทเหล่านี้กัน:

1. Web Scraper ที่สร้างเองเทียบกับ Web Scraper ที่สร้างไว้ล่วงหน้า

- Self-built Web Scraper คือ Web Scraper ที่ถูกเขียนโปรแกรมโดยโปรแกรมเมอร์ผู้เชี่ยวชาญโดยใช้ Python

- Web Scraper ที่สร้างไว้ล่วงหน้าต่างจาก Web Scraper ที่สร้างเอง ซึ่ง Web Scraper เหล่านี้ถูกสร้างขึ้นมาแล้ว และพร้อมให้ดาวน์โหลดได้ มักมาพร้อมกับตัวเลือกขั้นสูงที่ปรับแต่งได้ และเหมาะกับความต้องการของมือใหม่

2. ส่วนขยายเบราว์เซอร์ เทียบกับ ซอฟต์แวร์ Web Scraper

- ส่วนขยายเบราว์เซอร์ Web Scraper ถูกรวมไว้เป็นส่วนขยายในเบราว์เซอร์และใช้งานง่าย อย่างไรก็ตาม มักถูกจำกัดด้วยคุณสมบัติและความสามารถของเบราว์เซอร์ เว็บสเครเปอร์ประเภทนี้มักจะทำงานได้ดีกว่าบนเบราว์เซอร์แอนตี้เดเทค แต่จะอธิบายเพิ่มเติมเกี่ยวกับเบราว์เซอร์ประเภทหลัง

- ซอฟต์แวร์ Web Scraper สามารถดาวน์โหลดและติดตั้งบนคอมพิวเตอร์ได้ ส่วนขยายของเว็บสแครปเปอร์เหล่านี้มีความซับซ้อนมากกว่าส่วนขยายของเบราว์เซอร์ และมีคุณสมบัติขั้นสูงที่ไม่จำกัดเฉพาะความสามารถของเบราว์เซอร์

3. คลาวด์เทียบกับเว็บสแครปเปอร์แบบโลคัล

- คลาวด์เว็บสแครปเปอร์ทำงานนอกสถานที่ หรือตามชื่อที่บ่งบอก คือเซิร์ฟเวอร์บนคลาวด์ที่จัดทำโดยบริษัทของสแครปเปอร์ การดำเนินการดังกล่าวจะช่วยลดภาระของคอมพิวเตอร์ของคุณและดำเนินการขูดข้อมูลทั้งหมดโดยไม่มีการจำกัดความสามารถของฮาร์ดแวร์ของคอมพิวเตอร์ของคุณ

- Web Scrapers ท้องถิ่นทำงานบนคอมพิวเตอร์ของคุณ และจะใช้ความสามารถของซอฟต์แวร์และฮาร์ดแวร์ของคุณ

Web Scrapers ประเภทต่างๆ ทั้งหมดมีข้อดีและข้อเสียของตัวเอง ขึ้นอยู่กับกรณีการใช้งานของคุณ โดยรวมแล้ว เมื่อคุณพร้อมที่จะเริ่มทำเว็บสเครปปิ้ง จะมีเว็บสเครปปิ้งที่เหมาะกับความต้องการและความเชี่ยวชาญของคุณ

เว็บสเครปปิ้งใช้ทำอะไร?

ตอนนี้เรารู้แล้วว่าเว็บสเครปปิ้งคืออะไร ใช้เพื่ออะไร? หากการวิเคราะห์ข้อมูลมีความสำคัญ การรวบรวมข้อมูลก็มีความสำคัญเช่นกัน เช่นเดียวกับเว็บสเครปปิ้ง การรวบรวมข้อมูลเป็นส่วนสำคัญของธุรกิจหลายแห่ง ดังนั้น หากเราพิจารณาให้ถี่ถ้วน เราจะพบประโยชน์ของการดึงข้อมูล และเว็บสเครปปิ้งในภาคธุรกิจใดๆ ดังที่กล่าวไว้ นี่คือสามแอปพลิเคชันด่วน

1. การรวบรวมข้อมูลบนเว็บในธุรกิจค้าปลีกและอีคอมเมิร์ซ

ในภาคค้าปลีกและอีคอมเมิร์ซ ซึ่งมีการแข่งขันสูงและการรวบรวมข้อมูลเป็นสิ่งสำคัญ การรวบรวมข้อมูลบนเว็บจึงโดดเด่น หากคุณต้องการก้าวล้ำนำหน้าในอุตสาหกรรม คุณจะต้องเข้าถึงข้อมูลที่ถูกต้องอยู่เสมอ และนั่นคือสิ่งที่การรวบรวมข้อมูลบนเว็บทำได้

การรวบรวมข้อมูลบนเว็บช่วยให้คุณเข้าใจกลยุทธ์ที่คู่แข่งของคุณใช้เพื่อเพิ่มปริมาณการเข้าชมออนไลน์ได้ลึกซึ้งยิ่งขึ้น หากคุณสามารถเข้าถึงข้อมูลของคู่แข่งได้ผ่านเว็บสเครปปิ้ง คุณสามารถปรับเปลี่ยนกลยุทธ์การตลาดของคุณเองได้ ซึ่งจะช่วยเพิ่มประสิทธิภาพการขายได้ในที่สุด ผู้ให้บริการอย่าง Scrape Yogi นำเสนอบริการสเครปปิ้งที่แท้จริงให้กับแบรนด์อีคอมเมิร์ซ

2. เว็บสเครปปิ้งในด้านการเงินและเทคโนโลยีการเงิน

ในด้านการเงินและตลาดหุ้น เว็บสเครปปิ้งเป็นเครื่องมือที่มีประโยชน์ที่ช่วยรวบรวมข้อมูลหุ้น รายงานทางการเงิน และข้อมูลเกี่ยวกับการดำเนินงานของบริษัทการเงินบางแห่งแบบเรียลไทม์ คุณจะพบว่าข้อมูลนี้มีความสำคัญอย่างยิ่งในการตัดสินใจและวางแผนการลงทุน

นอกจากนี้ นักลงทุนในตลาดการเงินหลายรายยังใช้ประโยชน์จากเว็บสเครปปิ้ง (web scraping) เพื่อให้ได้ข้อมูลเชิงลึกเกี่ยวกับภูมิทัศน์ทางการเงิน ซึ่งทำให้พวกเขามองเห็นภาพรวมของโลกการเงินได้อย่างชัดเจน ช่วยให้ตัดสินใจได้อย่างรวดเร็วและชาญฉลาด

3. การขูดข้อมูลเว็บในด้านการตลาดดิจิทัลและ SEO

การขูดข้อมูลเว็บถูกนำมาใช้กันอย่างแพร่หลายในอุตสาหกรรมการตลาดดิจิทัลเพื่อรวบรวมข้อมูลอันมีค่าเกี่ยวกับความชอบของลูกค้า พฤติกรรมออนไลน์ หัวข้อที่เป็นกระแส และกลยุทธ์ของคู่แข่ง

หากคุณเป็นนักการตลาดดิจิทัล การใช้เทคนิคการขูดข้อมูลเว็บจะช่วยให้คุณได้รับข้อมูลเชิงลึกที่สามารถนำไปปฏิบัติได้ ซึ่งช่วยให้คุณปรับแต่งกลยุทธ์ของคุณได้แม่นยำยิ่งขึ้น วิธีนี้จะช่วยให้คุณก้าวล้ำหน้าแนวโน้มของผู้บริโภคออนไลน์ที่เปลี่ยนแปลงอยู่เสมอ

เครื่องมือที่คุณต้องมีเพื่อเริ่ม Web Scraping

ขึ้นอยู่กับประเภทของ Web Scraping ที่คุณต้องการดำเนินการ มีเครื่องมือหลักสามอย่างที่คุณต้องมี:

1. เบราว์เซอร์ Antidetect

เบราว์เซอร์ Antidetect ใช้เทคโนโลยีขั้นสูง เช่น การปลอมแปลงข้อมูล เพื่อปกป้องความเป็นส่วนตัวของผู้ใช้อินเทอร์เน็ต เบราว์เซอร์ Antidetect ชั้นนำบางรุ่น เช่น AdsPower ชั้นนำในอุตสาหกรรม ยังรองรับการจัดการโปรไฟล์หลายโปรไฟล์อีกด้วย คุณสามารถอ่านข้อมูลทั้งหมดเกี่ยวกับเบราว์เซอร์ antidetect ได้ในบทความเชิงลึกนี้

ทำไมคุณถึงต้องใช้เบราว์เซอร์ antidetect สำหรับการรวบรวมข้อมูลเว็บ? เว็บไซต์หลายแห่งใช้เทคโนโลยีการติดตามมากมาย เช่น คุกกี้ ลายนิ้วมือดิจิทัล และเว็บบีคอน เพื่อรวบรวมข้อมูลจากผู้เข้าชม ดังนั้น ในขณะที่คุณกำลังรวบรวมข้อมูลเว็บไซต์ เว็บไซต์นั้นอาจกำลังรวบรวมข้อมูลเกี่ยวกับคุณอยู่ ดังนั้นจึงจำเป็นต้องมีเบราว์เซอร์แอนตี้เดเทค

สำหรับเบราว์เซอร์แอนตี้เดเทคที่ผสานประสิทธิภาพและราคาที่เอื้อมถึง AdsPower คือตัวเลือกที่ดีที่สุด

2. Python

Python อาจเป็นภาษาโปรแกรมที่สำคัญที่สุดที่ควรเรียนรู้ หากคุณต้องการเป็นผู้เชี่ยวชาญในการดึงข้อมูลและการทำเว็บสเครปหลากหลายประเภท Python มีความหลากหลาย ทนทาน และเหมาะสมกับความต้องการของทั้งผู้เริ่มต้นและผู้เชี่ยวชาญ นอกจากนี้ ไลบรารีเว็บสเครปปิ้งยอดนิยมจำนวนมากยังสร้างขึ้นบน Python ด้วย

หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับ Python สำหรับการสเครปปิ้งเว็บ คุณสามารถไปที่ที่นี่.

3. ไลบรารีการขูดข้อมูลเว็บ

ไลบรารีเหล่านี้ทำหน้าที่เป็นกรอบงานที่แข็งแกร่งซึ่งช่วยเพิ่มประสิทธิภาพในการดึงข้อมูลจากเว็บไซต์ มีไลบรารียอดนิยมสี่ตัว

Beautiful Soup

Beautiful Soup เป็นไลบรารี Python ที่เชี่ยวชาญในการดึงข้อมูลจากไฟล์ HTML และ XML มันให้สำนวน Pythonic สำหรับการวนซ้ำ การค้นหา และการปรับเปลี่ยนโครงสร้างการแยกวิเคราะห์ ทำให้เป็นที่ชื่นชอบในหมู่เว็บสเครเปอร์เนื่องจากความเรียบง่ายและความหลากหลาย Beautiful Soup เหมาะอย่างยิ่งสำหรับการแยกวิเคราะห์เอกสาร HTML และ XML การนำทางแผนผังการแยกวิเคราะห์ และการดึงข้อมูลที่เกี่ยวข้อง

Scrapy

Scrapy เป็นกรอบการทำงานการรวบรวมเว็บแบบโอเพนซอร์สที่ทำงานร่วมกันสำหรับ Python ที่ช่วยเพิ่มประสิทธิภาพในการดึงข้อมูลจากเว็บไซต์ด้วยฟีเจอร์ในตัว Scrapy เหมาะอย่างยิ่งสำหรับความพยายามในการขูดข้อมูลเว็บขนาดใหญ่และเหมาะอย่างยิ่งสำหรับโครงการขนาดใหญ่

Pandas

Pandas เป็นไลบรารีการจัดการและวิเคราะห์ข้อมูลอันทรงพลังใน Python แม้ว่าจะไม่ใช่ไลบรารีสำหรับเว็บสเครปปิ้งโดยเฉพาะ แต่ก็มักใช้ร่วมกับไลบรารีอื่นๆ เพื่อจัดการและวิเคราะห์ข้อมูลที่สเครปปิ้งได้อย่างมีประสิทธิภาพ เหมาะอย่างยิ่งสำหรับการทำความสะอาด แปลง และวิเคราะห์ข้อมูลหลังการสเครปปิ้ง

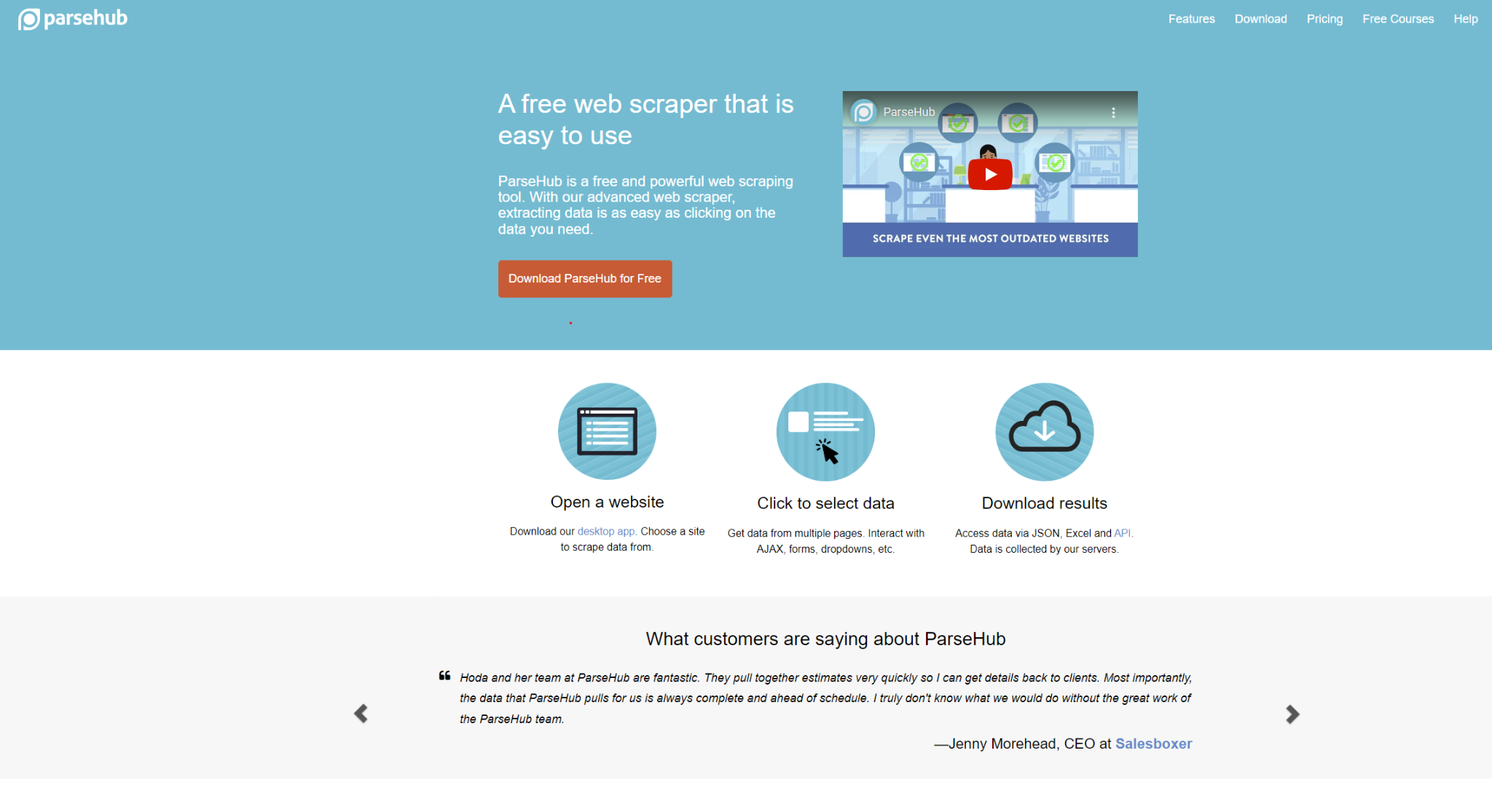

ParseHub

ParseHub โดดเด่นในฐานะเครื่องมือดึงข้อมูลภาพที่ช่วยเพิ่มประสิทธิภาพการทำเว็บสเครปปิ้งด้วยวิธีการชี้และคลิก ด้วยอินเทอร์เฟซที่ใช้งานง่าย จึงไม่จำเป็นต้องมีความรู้ด้านการเขียนโค้ดมากนัก เหมาะอย่างยิ่งสำหรับความต้องการของผู้ใช้ที่ต้องการอินเทอร์เฟซแบบภาพแต่ไม่มีความรู้ด้านการเขียนโปรแกรมเชิงลึก

ด้วยเครื่องมือเหล่านี้ คุณจะพร้อมสำหรับการเริ่มต้นเส้นทางการทำเว็บสเครปปิ้งของคุณ

วิธีเริ่มต้นใช้งาน Web Scraping

วิธีการเฉพาะสำหรับขั้นตอนเหล่านี้อาจแตกต่างกันไปขึ้นอยู่กับเครื่องมือที่คุณเลือก แต่เพื่อความง่าย เราจะเน้นที่ส่วนพื้นฐานที่ไม่ใช่เชิงเทคนิค ต่อไปนี้คือขั้นตอนต่อเนื่องที่คุณควรดำเนินการ:

ระบุ URL ที่ต้องการสแกน

แม้ว่าจะดูตรงไปตรงมา แต่ขั้นตอนแรกคือการกำหนดเว็บไซต์ที่คุณต้องการสแกน ตัวอย่างเช่น หากคุณมุ่งเน้นไปที่การสำรวจรีวิวหนังสือของลูกค้า คุณอาจกำหนดเป้าหมายข้อมูลที่เกี่ยวข้องจากแพลตฟอร์มต่างๆ เช่น Amazon, Goodreads หรือ LibraryThing

ตรวจสอบหน้าเว็บ

ก่อนที่จะเขียนโค้ดเว็บสเครเปอร์ สิ่งสำคัญคือต้องเข้าใจว่าจำเป็นต้องรวบรวมข้อมูลใดบ้าง การคลิกขวาที่ใดก็ได้บนส่วนหน้าของเว็บไซต์จะมีตัวเลือกต่างๆ เช่น 'ตรวจสอบองค์ประกอบ' หรือ 'ดูแหล่งที่มาของหน้า' การดำเนินการนี้จะเปิดเผยโค้ดพื้นฐานของเว็บไซต์ ซึ่งทำหน้าที่เป็นแหล่งข้อมูลสำหรับเครื่องมือสแกนข้อมูล นอกจากนี้ คุณยังสามารถใช้เครื่องมือสแกนข้อมูลบนเว็บที่สร้างไว้ล่วงหน้าได้อีกด้วย

เริ่มการสแครป

เมื่อคุณได้ระบุ URL ที่เกี่ยวข้องและตรวจสอบโครงสร้างหน้าเว็บเรียบร้อยแล้ว ก็ถึงเวลาเริ่มขั้นตอนการสแครป ซึ่งเกี่ยวข้องกับการนำโค้ดที่จำเป็นไปใช้ หรือใช้เครื่องมือสแครปเว็บเพื่อดึงข้อมูลที่ต้องการจากเว็บไซต์ที่คุณกำหนดเป้าหมาย วิธีการเฉพาะสำหรับการดำเนินการขั้นตอนนี้อาจแตกต่างกันไปขึ้นอยู่กับเครื่องมือที่เลือกใช้ แต่เป้าหมายพื้นฐานยังคงเหมือนเดิม นั่นคือการรวบรวมข้อมูลที่มีค่าจากเว็บอย่างเป็นระบบ

บทสรุป

เมื่อเวลาผ่านไป การรวบรวมข้อมูลบนเว็บได้พัฒนาไปอย่างมากจนกลายเป็นส่วนสำคัญอย่างยิ่งของการวิเคราะห์ข้อมูล และรวมถึงธุรกิจทั่วโลกด้วย การรวบรวมข้อมูลนี้ช่วยให้ธุรกิจต่างๆ สามารถดึงและวิเคราะห์ข้อมูลจำนวนมหาศาลจากอินเทอร์เน็ตได้อย่างมีประสิทธิภาพ และเมื่อเทคโนโลยีก้าวหน้าขึ้น บทบาทของการรวบรวมข้อมูลบนเว็บก็มีแนวโน้มที่จะขยายตัวเพิ่มขึ้น ในไม่ช้า การรวบรวมข้อมูลบนเว็บจะเริ่มนำเสนอวิธีการที่ซับซ้อนยิ่งขึ้นสำหรับองค์กรต่างๆ ในการใช้ประโยชน์จากข้อมูลอันมากมายบนอินเทอร์เน็ต

บทความนี้เป็นเพียงหนึ่งในแหล่งข้อมูลฟรีมากมายที่สามารถเข้าถึงได้บน เว็บไซต์ AdsPower AdsPower นำเสนอสื่อการเรียนรู้ที่หลากหลาย รวมถึงคู่มือและบทช่วยสอน เยี่ยมชมเว็บไซต์ของเราวันนี้เพื่อเข้าถึงเนื้อหาอื่นๆ ที่ทั้งฟรีและมีประโยชน์

คนยังอ่าน

- วิธีแก้ไขข้อผิดพลาดของ ChatGPT: ปัญหาเกี่ยวกับเครือข่าย สตรีมข้อความ และการเข้าถึง

วิธีแก้ไขข้อผิดพลาดของ ChatGPT: ปัญหาเกี่ยวกับเครือข่าย สตรีมข้อความ และการเข้าถึง

แก้ไขข้อผิดพลาดของ ChatGPT ที่เกิดจากการหลุดเครือข่าย การหยุดชะงักของกระแสข้อความ และปัญหาการเข้าถึง ใช้ขั้นตอนที่รวดเร็วและใช้งานได้จริงเพื่อกู้คืนการตอบสนองที่เสถียร

- วิธีแก้ไขปัญหาการถูกแบน IP บน Discord ในปี 2026?

วิธีแก้ไขปัญหาการถูกแบน IP บน Discord ในปี 2026?

การแบน IP ใน Discord จะปิดกั้นการเข้าถึงเครือข่ายของคุณ คู่มือฉบับปี 2026 นี้จะอธิบายวิธีการตรวจจับ กู้คืน อุทธรณ์ และป้องกันการจำกัด IP เพื่อให้คุณสามารถเชื่อมต่อได้อีกครั้ง

- ประเภทของเว็บเบราว์เซอร์ในปี 2026: เว็บเบราว์เซอร์ยอดนิยมและเว็บเบราว์เซอร์ขั้นสูง

ประเภทของเว็บเบราว์เซอร์ในปี 2026: เว็บเบราว์เซอร์ยอดนิยมและเว็บเบราว์เซอร์ขั้นสูง

สำรวจประเภทของเว็บเบราว์เซอร์ในปี 2026 ตั้งแต่เว็บเบราว์เซอร์ยอดนิยมไปจนถึงเบราว์เซอร์เพื่อความเป็นส่วนตัวและป้องกันการตรวจจับ เรียนรู้ว่ามีกี่ประเภท และเลือกเบราว์เซอร์ที่เหมาะสม

- วิธีปลดบล็อก TamilMV อย่างปลอดภัยและเข้าถึงภาพยนตร์ทมิฬออนไลน์ (คู่มือปี 2026)

วิธีปลดบล็อก TamilMV อย่างปลอดภัยและเข้าถึงภาพยนตร์ทมิฬออนไลน์ (คู่มือปี 2026)

เรียนรู้วิธีปลดบล็อก TamilMV อย่างปลอดภัยในปี 2026 เข้าถึงภาพยนตร์ทมิฬ (MV) เปรียบเทียบพร็อกซี VPN และเบราว์เซอร์ป้องกันการตรวจจับ เพื่อการเข้าถึงออนไลน์ที่ปลอดภัยและเสถียร

- วิธีดาวน์โหลดวิดีโอจาก Reddit ในปี 2026: ไฟล์ MP4, GIF และรูปภาพ ทำได้ง่ายๆ

วิธีดาวน์โหลดวิดีโอจาก Reddit ในปี 2026: ไฟล์ MP4, GIF และรูปภาพ ทำได้ง่ายๆ

เรียนรู้วิธีดาวน์โหลดวิดีโอ GIF และรูปภาพจาก Reddit อย่างง่ายดายและปลอดภัยในปี 2026 พร้อมขั้นตอนการใช้งาน เคล็ดลับการแก้ไขปัญหา และแนวทางปฏิบัติที่ดีที่สุด