什麼是網絡爬蟲? | 爬取網頁數據的完整指南

你是否經常需要手動從上百個網頁中複製粘貼信息,卻髮現過程枯燥、耗時,還容易出錯?在數據驅動的時代,這種低效的方式正逐漸被網絡爬蟲技術所取代。

網絡爬蟲是一種能夠自動化執行網絡爬取的程序,它能像用戶一樣訪問網頁,並快速、批量地完成爬取網頁數據的工作。無論是電商平颱的商品信息、社交媒體的運營數據,還是新聞網站的內容更新,都可以通過網絡爬蟲實現高效獲取。

本篇文章將作爲一份完整的網絡爬蟲指南,帶你從零開始理解網絡爬蟲,學會如何高效、合規地爬取網頁數據,並應對過程中的各種挑戰。

什麼是網絡爬蟲?

想象一下,互聯網是一座巨大的數字圖書館,網頁是一本本散落在各處的書籍。手工去每一本書裡查找並摘錄信息既耗時又容易出錯。

網絡爬蟲就像圖書館裡的自動採集員:按照事先設定的路線走遍書架(網頁),把需要的信息找到、摘錄並存到數據庫裡,供後續檢索或分析使用。

從技術角度來講,網絡爬蟲是一種按照預設規則,自動抓取網頁信息的程序或腳本。這些規則由開髮者設定,告訴爬蟲應該從哪些網站(種子URL)開始、需要抓取哪些類型的內容(如文本、圖片、鏈接)、以多快的速度進行(請求頻率),以及將抓取到的數據存儲在哪裡(數據庫或文件)。它的工作基礎是HTTP/HTTPS協議,通過向網頁服務器髮送請求並解析返回的HTML代碼來獲取信息。

在實際討論中,有三個詞常被交替使用,你可以通過以下解釋來理解:

-

爬蟲 (Crawler/Spider):通常指具體實現的程序或“機器人”。比如你冩的Python腳本、一個Scrapy項目或一個自動化瀏覽器實例,都可以稱爲一個爬蟲。它是“實體”。

-

爬取 (Crawling):強調的是過程與行爲——在網站間按鏈接遍曆、髮現和下載頁麵的動作。蒐索引擎做的是大規模的爬取,用來建立網頁索引。

-

抓取(Scraping):更側重於從某個或某些頁麵中抽取結構化信息的動作。抓取關注的是“把需要的數據抽出來並結構化保存”,例如把商品名、價格、庫存等字段提取成表格。

簡單來説,爬蟲這個工具,通過爬取的方式來瀏覽互聯網,並執行抓取來獲得所需數據。這三個環節共同構成了完整工作流。理解了這些基本概唸,我們就能更好地探索網絡爬蟲究竟能爲我們做些什麼。

爲什麼要進行網絡爬取?網絡爬蟲的強大用途

我們生活在一個由數據驅動的時代。信息,尤其是那些隱藏在公開網絡中的海量信息,已經成爲了洞察市場、指導決策、推動創新的關鍵資産。然而,這些有價值的數據往往分散在成千上萬個網頁中,手動收集不僅效率極其低下,而且難以形成規模,無法滿足現代商業和研究的需要。網絡爬取充當了數據世界與本地分析之間的橋梁,將公共信息轉化爲可操作的智能。

那麼,網絡爬蟲具體能在哪些場景中髮揮其用途呢?以下是一些核心的應用領域。

1. 價格監控

對於任何一家電商企業而言,定價策略直接關繫到市場競爭力。許多賣家和平颱都會利用爬蟲來爬取網頁數據,7x24小時不間斷地監控競爭對手商品的價格、庫存變化與促銷活動。例如,當爬蟲髮現競爭對手的某款熱門手機缺貨時,本企業可以迅速決策,是否維持原價或進行小幅上調以優化利潤。

對跨境電商賣家而言,網絡爬取還能幫助他們監控不同國家和平颱的市場差異,及時製定全球定價和營銷策略。

2. 市場研究與商業情報

除了直接的商業競爭,網絡爬取更是市場研究的利器。無論是投資機構評估一個行業的前景,還是初創公司尋找市場切入點,都需要基於大量客觀數據。網絡爬蟲可以:

-

收集新聞與行業報告: 追踪特定關鍵詞下的最新報道和分析。

-

分析社交媒體趨勢: 從微博、小紅書、推特、YouTube等平颱抓取公衆對某個話題的討論,進行數據和輿情分析。

-

聚合用戶評論: 從電商平颱、應用商店、旅遊網站抓取海量用戶評論,通過情感分析模型了解用戶對産品或服務的真實反饋和痛點,爲産品改進提供方向。

3. 蒐索引擎優化(SEO)

我們日常使用的谷歌、百度等蒐索引擎,之所以能在一秒內提供海量結果,其背後正是由極其複雜的巨型網絡爬蟲(如Googlebot、百度蜘蛛)所支撐。

這些爬蟲日夜不停地遍曆互聯網上的數十億個網頁,通過網頁內容爬取來理解每個頁麵的主題、關鍵詞和權重,並爲其建立索引。當我們進行蒐索時,蒐索引擎實際上是在這個預先建立好的、龐大的索引庫中進行檢索和排序。因此,理解爬蟲的工作原理,本身也是做好SEO優化、讓網站獲得更好排名的關鍵。

4. 學術研究

在人文社科、金融分析、公共衛生等領域,研究人員需要分析大量的公開數據。網絡爬蟲能夠幫助他們自動化地收集這些數據集。例如:

-

社會輿情分析: 研究公衆對某項政策的態度演變。

-

金融數據分析: 抓取上市公司財報、股票曆史數據等。

-

語言學研究: 收集網絡用語,分析語言的變化趨勢。

5. 品牌監控

對於現代企業而言,品牌聲譽是生命線。網絡爬蟲可以作爲一種高效的“雷達繫統”,自動跟踪新聞網站、論壇、博客、視頻平颱等渠道上所有關於企業品牌和産品的提及。一旦髮現重大的負麵評價或公關危機苗頭,繫統可以立即髮出警報,使公關團隊能夠第一時間介入處理,將潛在的損失降到最低。同時,收集到的正麵評價也能成爲市場宣傳的寶貴素材。

爬蟲是如何爬取網頁數據的?

1. 確定目標URL

首先,網絡爬蟲從一個或多個初始網址開始,也就是“種子URL”。開髮者會將目標網站的首頁、分類頁麵或特定的列表頁作爲起點,設定爬取範圍。

2. 髮送HTTP請求

拿到URL後,爬蟲會扮演一個瀏覽器的角色,向目標網頁的服務器髮送一個HTTP請求。這個過程類似於你在瀏覽器地址欄輸入網址後按下回車鍵。服務器接收到這個請求後會做出響應,將網頁的源代碼(通常是HTML格式)返回給爬蟲。

3. 解析與提取所需數據

爬蟲拿到服務器返回的HTML代碼後,並不會直接存儲這些雜亂無章的原始代碼。相反,它會根據預設的規則(例如,尋找特定的HTML標籤、CSS選擇器或XPath路徑)來定位並提取出有價值的信息。比如,要抓取産品價格,爬蟲就會被設定爲尋找包含價格的特定<span>標籤。

4. 存儲已提取的數據

成功提取出目標數據(如商品名稱、價格、評論數)後,爬蟲需要將這些信息妥善地保存起來。根據項目的需求,數據可以被存儲到多種形式的“倉庫”中,例如CSV或Excel文件、JSON文件,或者更專業的數據庫(如MySQL、MongoDB)中,便於後續的數據分析和應用。

5. 跟踪鏈接並循環往複

網絡爬蟲的真正威力在於其自動化遍曆能力。在解析頁麵時,它會同時識別頁麵上的所有或符合特定條件的超鏈接(例如,隻抓取“下一頁”或同一域名下的鏈接)。將這些新髮現的URL添加到一個待抓取的隊列中,然後重複步驟二到步驟四的過程。

這個“請求-解析-存儲-髮現”的循環會持續進行,直到滿足某個停止條件爲止,例如:抓取完所有髮現的鏈接、達到預設的頁麵數量限製,或者觸髮了網站的反爬蟲機製。

網絡爬取的主要挑戰

雖然網絡爬蟲能夠高效收集信息,但在實際應用中卻常常遭遇阻力。最大的問題在於:很多網站會主動阻止爬蟲訪問,即反爬蟲機製。這並不是因爲數據毫無價值,而是出於多方麵的考慮。

爲什麼網站會阻止爬蟲?

-

資源消耗

爬蟲往往會在短時間內髮出成百上千次請求,佔用服務器帶寬和計算資源。如果爬蟲規模過大,可能導緻網站變慢甚至宕機,影響正常用戶的訪問體驗。

-

數據安全與版權

網站上的數據是其核心資産,尤其是電商價格、新聞內容、數據庫信息等。一旦被大規模抓取,可能會侵犯版權或造成數據洩露。

-

不公平競爭

行業內的競爭者可能利用爬蟲獲取敏感數據,如定價策略或用戶行爲,從而在市場競爭中不正當獲利。

-

隱私保護

網站需要保護用戶的個人信息和行爲數據,防止被噁意爬蟲批量收集後,用於垃圾營銷甚至違法用途。

網站如何檢測和阻止爬蟲?

網站會運用多種技術手段來區分訪客是真實的人類還是自動化爬蟲。

-

IP地址頻率監控:正常人類瀏覽網頁時,請求是間歇性的。而爬蟲則會在短時間內髮起密集請求。如果服務器檢測到來自同一個IP地址的請求頻率異常高,就會判定其爲爬蟲,並暫時或永久地封禁該IP。

-

User-Agent檢測:每個正常的瀏覽器在髮送請求時,都會附帶一個名爲“User-Agent”的字符串,用以標識自己的身份。服務器會檢查這個標識,非主流或可疑的User-Agent會直接被拒絶訪問。

-

行爲分析:人類的操作具有隨機性,比如移動鼠標軌跡不規則、在頁麵上停留時間不確定、點擊間隔有長有短。而爬蟲的行爲則非常規律和機械化,例如精準地點擊某個鏈接、頁麵停留時間完全相同、以固定速度翻頁。網站通過分析這些行爲模式,可以精準地識別出爬蟲。

-

JavaScript挑戰:現代網站大量使用JavaScript來動態加載內容。簡單爬蟲無法執行JS代碼,因此它們獲取的頁麵隻是一個空殼,看不到真正的內容。網站通過這種方式可以輕易地阻擋初級爬蟲。

-

驗証碼(CAPTCHA):當繫統檢測到可疑行爲時,會彈出驗証碼要求用戶進行識別。這是爬蟲程序難以逾越的障礙。

-

高級指紋識別:這是目前最先進的檢測技術。網站會通過腳本收集你瀏覽器的數十種特徵,如安裝的字體列表、屏幕分辨率、Canvas圖像渲染方式、WebGL顯卡信息、時區、語言設置等。這些信息組合起來,可以生成一個幾乎唯一的“瀏覽器指紋”。即使你更換了IP,但隻要指紋不變,網站依然可以識別並追踪到你。

如何合規地應對阻止?安全爬取的最佳實踐

尊重robots.txt

robots.txt 是放在網站根目錄下的一個文本文件,它會明確告知爬蟲,哪些目錄或文件是允許抓取的,哪些是禁止訪問的。在開始任何爬取網頁數據的任務之前,首先檢查 https://目標網站.com/robots.txt 並遵守其規定。

設置合理的請求頻率

在你的爬蟲程序中,必須在每次請求之間引入隨機的延時。例如,在請求間隔中加入2到5秒,甚至更長的等待時間。這能有效避免因請求過快而觸髮基於IP的頻率限製,是減輕服務器壓力的最直接方式。

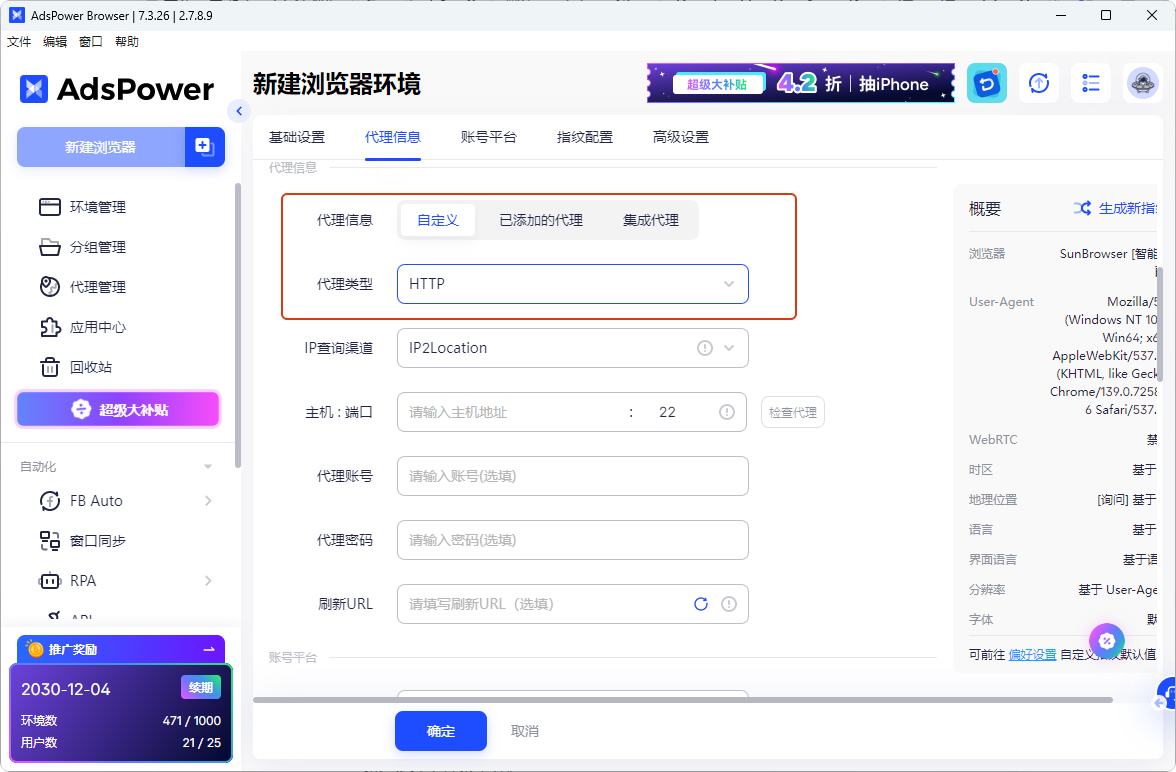

使用代理IP池

當採集任務量較大時,容易因同一IP請求過多而被封禁。這時,你需要使用代理IP池。通過輪換使用多個不同的IP地址來髮送請求,可以將抓取負載分散到許多個“身份”上,使得每個IP的請求頻率都保持在正常範圍內。

使用真實的請求頭

一個不帶任何標識的HTTP請求是極其可疑的。務必爲你的爬蟲配置完整的、真實的HTTP請求頭信息,特別是User-Agent,應將其設置爲常見的瀏覽器標識(如Chrome、Firefox的最新版)。此外,合理設置Referer(來源頁)等頭部信息,也能讓請求看起來更加自然,輕鬆繞過基礎的User-Agent檢測。

使用反檢測瀏覽器

在一些需要大規模、多賬號數據採集的場景中,單純依靠腳本往往難以繞過複雜的反爬機製。建議使用反檢測瀏覽器提高網頁數據抓取的成功率。

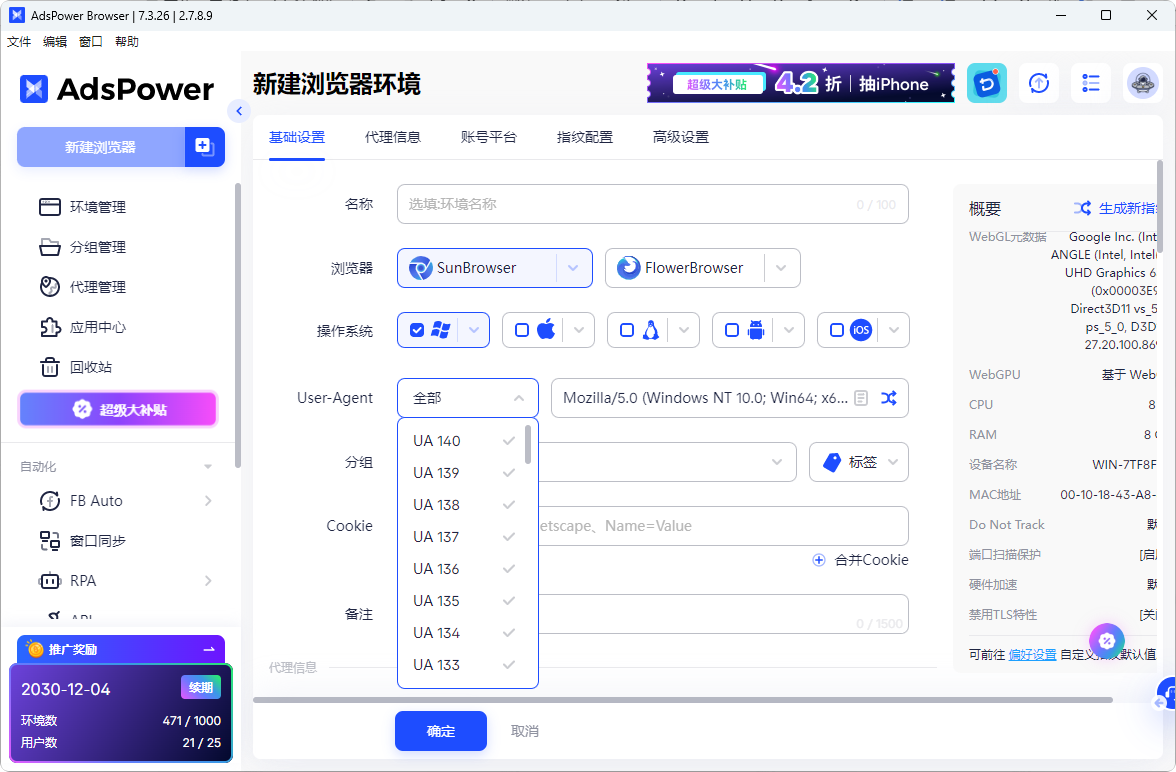

以AdsPower爲代表的反檢測瀏覽器,其核心作用就是爲每個爬蟲任務創建一個獨立的、擁有唯一且可信瀏覽器指紋的隔離環境。它能夠深度模擬不同的User-Agent、操作繫統、瀏覽器版本、屏幕分辨率、字體列表、Canvas和WebGL渲染效果等參數。

網站在檢測時,會認爲每個由AdsPower創建的爬蟲實例都是來自世界各地不同設備的真實用戶,從而有效地繞過了最棘手的指紋識別,大大降低被封鎖的風險。它與代理IP配合使用,構成一套強大的反爬蟲應對方案。

AdsPower的Local API功能提供了更高的靈活性,允許開髮者將這些偽裝好的瀏覽器環境與Selenium、Puppeteer等主流的瀏覽器自動化框架無縫集成,從而自動化執行複雜的交互操作,如填冩表單、點擊按鈕、處理下拉菜單等。

最後,如果目標網站明確禁止爬蟲,或者反爬機製非常嚴格,可以嚐試通過網站API、數據開放平颱、第三方數據服務等替代方式來獲取所需信息。總體來説,合規地應對阻止是通過合理策略和合適工具,在尊重網站和用戶權益的前提下,實現高效的數據獲取。

END

總而言之,網絡爬蟲作爲一項強大的自動化技術,是我們在信息時代高效獲取網絡公開數據的關鍵工具。成功的爬取網頁數據項目,本質上是一項需要精細平衡技術能力、法律合規性以及對目標網站資源尊重的工作。隻有深刻理解其內在機製,並遵循最佳實踐,才能負責任且可持續地利用這一技術。希望這篇指南能爲你提供清晰的路徑,讓網絡爬蟲真正成爲你工作和研究的得力助手。

關於網絡爬蟲的常見問題解答

網絡爬蟲合法嗎?

爬取公開數據通常合法,但必須遵守網站的服務條款、robots.txt文件,並尊重版權和隱私法律。切勿爬取個人敏感信息或用於噁意目的。

學習網絡爬蟲需要什麼編程基礎?

Python是最受歡迎的語言,因其有豐富的庫(如Requests, BeautifulSoup, Scrapy)。具備基本的HTML/CSS知識對解析網頁至關重要。

爬蟲和API有什麼區別?

API是網站官方提供的、結構化的數據接口,更穩定、合規。而爬蟲是從網頁界麵直接提取數據,通常在網站不提供API或API限製較多時使用。

如何爬取需要登錄或由JavaScript動態加載的內容?

需要使用像Selenium、Playwright或Puppeteer這樣的工具來模擬瀏覽器行爲,處理登錄會話和執行JavaScript。

人們也讀過

- AI搜尋可見性追蹤工具:如何在AI語言模型中追蹤品牌可見性

AI搜尋可見性追蹤工具:如何在AI語言模型中追蹤品牌可見性

了解關鍵指標、追蹤方法以及監控 AI 語言模型如何提及您的品牌的最佳工具。

- 2026 TikTok Shop 開店全攻略:新手入門、選品運營與規模化擴張指南

2026 TikTok Shop 開店全攻略:新手入門、選品運營與規模化擴張指南

2026 TikTok Shop 最新教學,涵蓋賣家註冊、熱銷選品、流量獲取、聯盟行銷策略及帳號安全管理,助您搶佔跨境電商商機。

- 如何修復 ChatGPT 錯誤:網路、訊息流和存取問題

如何修復 ChatGPT 錯誤:網路、訊息流和存取問題

修復由網路中斷、訊息流中斷和存取問題引起的 ChatGPT 錯誤。使用快速簡便的步驟來恢復穩定的反應。

- 如何解決 Discord 上的 IP 封鎖問題(2026 年版)?

如何解決 Discord 上的 IP 封鎖問題(2026 年版)?

Discord IP封鎖會阻止您的網路存取。本指南(2026年版)說明如何偵測、恢復、申訴和阻止IP限制,以便您可以重新連線。

- 2026 中國國內用戶登陸 TikTok 國際版全攻略:註冊、登入與養號指南

2026 中國國內用戶登陸 TikTok 國際版全攻略:註冊、登入與養號指南

國內用戶必看! 2026 年最新 TikTok 國際版註冊與登入完整指南,詳細講解如何在國內安全搭建帳號環境、順利註冊帳號、完善個人資料及穩定養號,協助新號快速獲得推薦、提升曝光與互動,輕鬆開啟 TikTok 創作之旅。