นี่คือวิธีการขูด Reddit ใน 2 วิธีที่แตกต่างกันแต่มีประสิทธิภาพ

เป็นเรื่องที่ไม่ต้องคิดมากเลยว่าข้อมูลที่ผู้ใช้สร้างโดย Reddit นั้นมีคุณค่ามหาศาล ถึงขนาดที่Google และ OpenAI ใช้มันเพื่อฝึกฝนโมเดลภาษาขนาดใหญ่ (LLMs) ของพวกเขา

แต่จะรวบรวมข้อมูลจาก Reddit และใช้ประโยชน์จากมูลค่าของมันได้อย่างไรโดยไม่ต้องเสียแรงและเสียเงินมากมาย?

ไม่ว่าคุณจะเป็นโค้ดเดอร์ผู้มากประสบการณ์หรือเป็นคนที่ไม่รู้จักโลกอันซับซ้อนของการเขียนโปรแกรม ก็มีวิธีที่ถูกปรับแต่งมาสำหรับคุณโดยเฉพาะ

ในบล็อกนี้ คุณจะได้เรียนรู้วิธีรวบรวมข้อมูลจาก Reddit โดยใช้สองวิธีง่ายๆ และรับข้อมูลอันมากมายที่ Reddit นำเสนอ

แต่ก่อนจะลงรายละเอียดเกี่ยวกับวิธีการขูดข้อมูลบน Reddit มาดูวิธีต่างๆ ในการขูดข้อมูลบน Reddit กันแบบรวดเร็ว

วิธีการต่างๆ ในการรวบรวมข้อมูลบน Reddit

ผู้คนรวบรวมข้อมูลบน Reddit มากมายหลายวิธี แต่ละวิธีมีข้อดีและข้อเสีย

บางส่วนนั้นง่ายเหมือนเดินในสวนสาธารณะ ไม่ต้องใช้ทักษะทางเทคนิคใดๆ ในขณะที่บางส่วนนั้นยากและต้องมีความรู้ด้านการเขียนโปรแกรมระดับปานกลางถึงสูง

มาแนะนำวิธีต่างๆ ในการรวบรวมข้อมูลจาก Reddit กันแบบคร่าวๆ

การรวบรวมข้อมูล Reddit ด้วยตนเอง

สื่อต่างๆ เช่น รูปภาพและรูปโปรไฟล์สามารถดาวน์โหลดได้อย่างง่ายดายจากแพลตฟอร์ม ในขณะที่สามารถแยกวิดีโอได้โดยใช้เว็บไซต์ดาวน์โหลดวิดีโอของบุคคลที่สาม

อย่างไรก็ตาม เนื่องจากกระบวนการทั้งหมดเป็นแบบแมนนวล จึงต้องใช้เวลามากหากคุณต้องการมาก นอกจากนี้ การรวบรวมข้อมูล Reddit ด้วยตนเองยังเพิ่มโอกาสเกิดข้อผิดพลาดจากมนุษย์อีกด้วย

ขูด Reddit โดยใช้ API ของมัน

จากนั้นยังมีกฎเกณฑ์จำกัดอื่นๆ ที่กำหนดโดย Reddit ซึ่งคุณต้องปฏิบัติตามเพื่อใช้ API นอกจากนี้ หลังจากข้อโต้แย้งของ Reddit ปี 2023 API นี้มาพร้อมกับค่าธรรมเนียม และจะยังคงใช้งานได้ฟรีสำหรับนักพัฒนาเครื่องมือการดูแลหรือวัตถุประสงค์ทางวิชาการเท่านั้น

สร้าง Reddit Scraper แบบกำหนดเอง

ตัวเลือกถัดไปของคุณคือการรวบรวมข้อมูลจาก Reddit โดยไม่ต้องใช้ API โดยการสร้างเครื่องมือรวบรวมข้อมูล Reddit แบบกำหนดเองขึ้นมาใหม่ตั้งแต่ต้น วิธีนี้ค่อนข้างยากเนื่องจากต้องใช้ทักษะการเขียนโปรแกรมขั้นสูง แต่มีแนวโน้มสูงหากคุณสามารถจัดการได้

วิธีนี้ช่วยให้คุณปรับแต่งเครื่องมือสแกนข้อมูลเพื่อดึงข้อมูลประเภทใดก็ได้ที่เครื่องมือสแกนข้อมูลสำเร็จรูปอื่นๆ อาจไม่สามารถดึงข้อมูลได้ นอกจากนี้ คุณยังสามารถเขียนสคริปต์เพื่อปรับขนาดงานสแกนข้อมูลให้เหมาะกับความต้องการของคุณได้

อย่างไรก็ตาม การพัฒนาเครื่องมือขูดข้อมูล Reddit แบบกำหนดเองนั้นไม่ใช่เรื่องง่าย และยังต้องใช้ต้นทุนและเวลามากอีกด้วย

ใช้ Reddit Scraper แบบไม่ต้องเขียนโค้ด

ไม่มีพื้นหลังการเขียนโค้ดเหรอ? ไม่ใช่เรื่องใหญ่ มีเครื่องมือขูดข้อมูลมากมายที่ไม่ต้องเขียนโปรแกรม

เครื่องมือเหล่านี้มาในรูปแบบซอฟต์แวร์ที่ใช้งานง่ายหรือส่วนขยายเบราว์เซอร์ และให้คุณรวบรวมข้อมูลจาก Reddit ได้ภายในเวลาไม่กี่นาทีหลังจากคลิกเมาส์เพียงไม่กี่ครั้ง

ด้านที่สดใสจริงๆ คือเครื่องมือเหล่านี้ส่วนใหญ่มีแผนฟรีที่มักจะเพียงพอสำหรับผู้ใช้ส่วนใหญ่

วิธีการขูดข้อมูลจาก Reddit โดยใช้โค้ดและไม่ใช้โค้ด?

เอาล่ะ โดยไม่ต้องเสียเวลาต่ออีก มาลงมือทำธุรกิจและค้นพบวิธีรวบรวมข้อมูลบน Reddit โดยใช้ Reddit Scraper ที่ไม่ต้องใช้โค้ดและไลบรารี Python กันดีกว่า

การขูดข้อมูล Reddit โดยใช้ Parsehub (ไม่มีโค้ด)

การขูดข้อมูลจาก Reddit ด้วยตนเองอาจใช้เวลานานมาก ขณะค้นหาโพสต์ เปิดโพสต์ รอให้โหลด แล้วจึงค่อย การคัดลอกและวางข้อมูลลงในสเปรดชีตนั้นทำได้ แต่ก็ยังไม่เกิดประโยชน์ โดยเฉพาะอย่างยิ่งเมื่อต้องจัดการกับโพสต์จำนวนหลายร้อยโพสต์

ให้เครื่องมือขูดเว็บอัตโนมัติจัดการงานนี้ให้คุณ เครื่องมือเหล่านี้ช่วยให้คุณขูดข้อมูลเกือบทุกประเภทจาก Reddit โดยอัตโนมัติ รวมถึงชื่อผู้ใช้ ลิงก์ หัวข้อโพสต์ วันที่ รูปภาพ และความคิดเห็น เพื่อตั้งชื่อให้กับคนบางกลุ่ม

ดังที่ได้กล่าวไว้ก่อนหน้านี้ การรวบรวมข้อมูลบน Reddit โดยใช้เครื่องมือที่ไม่ต้องใช้โค้ดนั้นเป็นเรื่องง่าย แต่คุณต้องการคำแนะนำเพื่อเริ่มต้นใช้งาน

มาเรียนรู้วิธีรวบรวมข้อมูลบน Reddit โดยใช้ ParseHub กันดีกว่า

-

ดาวน์โหลด ParseHub: เข้าไปที่ เว็บไซต์ ParseHub และเลือกตัวเลือกการดาวน์โหลดที่เหมาะสมกับระบบปฏิบัติการของคุณ โปรแกรมติดตั้งจะดาวน์โหลด เรียกใช้โปรแกรมติดตั้ง แล้ว ParseHub จะติดตั้งภายในไม่กี่นาที

-

สร้างบัญชี: หากคุณใช้ ParseHub เป็นครั้งแรก คุณจะต้องสมัครสมาชิกและสร้างบัญชี กระบวนการนี้รวดเร็วสุดๆ เพียงกรอกชื่อ อีเมล และรหัสผ่านของคุณ คุณก็จะเข้าสู่ระบบบัญชีใหม่ของคุณได้

-

เริ่มโครงการใหม่: บนหน้าจอหลัก คลิกปุ่มโครงการใหม่

-

บนหน้าจอใหม่ ให้วางลิงก์ subreddit ที่คุณต้องการขูดข้อมูล เราขอแนะนำให้คุณใช้เลย์เอาต์เก่าของ Reddit เพราะใช้งานได้ดีที่สุดสำหรับการขูดข้อมูล

-

พวกเราจะทำการรวบรวมข้อมูลจาก subreddit ของ NBA เพื่อการสาธิต

-

กดปุ่มเริ่ม แล้ว subreddit จะโหลดขึ้นบนหน้าจอหลัก

-

เลือกข้อมูลที่เกี่ยวข้อง: สมมติว่าเราต้องการรวบรวมชื่อเรื่องและลิงก์ของโพสต์ทั้งหมด คลิกที่ชื่อเรื่องของโพสต์แรกบนเพจ โพสต์ที่เลือก ชื่อเรื่องจะเปลี่ยนเป็นสีเขียว และชื่อเรื่องของโพสต์อื่นๆ จะเปลี่ยนเป็นสีเหลือง จากนั้นให้เลือกชื่อเรื่องของโพสต์ที่สอง และชื่อเรื่องทั้งหมดจะเปลี่ยนเป็นสีเขียว แสดงว่าได้เลือกทั้งหมดแล้ว

-

ที่แผงด้านข้าง ให้ตั้งชื่อที่เหมาะสมให้กับส่วนที่เลือก เช่น โพสต์

-

สร้างการเลือกเพิ่มเติม: สมมติว่าเราต้องการวันที่ของแต่ละโพสต์ด้วย โดยคลิกที่สัญลักษณ์ "+" บนการเลือกโพสต์ และเลือกการเลือกแบบสัมพัทธ์

-

ตอนนี้คลิกที่หัวเรื่องของโพสต์แรก และหลังจากนั้น คลิกที่ประทับเวลาของโพสต์ ทั้งหน้าจะเริ่มมีลักษณะแบบนี้

-

เปลี่ยนชื่อการเลือกที่สร้างใหม่เป็นวันที่

-

การเลือกวันที่ดึงข้อมูลประทับเวลาที่เกี่ยวข้องออกมา แต่เราต้องการวันที่และเวลาของโพสต์ ดังนั้น ให้คลิกที่สัญลักษณ์ "+" ที่อยู่ถัดจากการเลือกวันที่ คลิก "ขั้นสูง" เพื่อเปิดเมนูทั้งหมด แล้วเลือก "ดึงข้อมูล"

-

เปิดเมนูแบบดรอปดาวน์ถัดไปเพื่อแยกและเลือกแอตทริบิวต์ชื่อ

-

คุณจะสังเกตได้ว่าการเลือกจะดึงวันที่และเวลาในขณะนี้

-

ทำซ้ำสำหรับประเภทข้อมูลเพิ่มเติม: ทำซ้ำขั้นตอนก่อนหน้าสำหรับชื่อผู้ใช้ จำนวนความคิดเห็น และการโหวต

-

เพิ่มการแบ่งหน้า: ส่วนที่เลือกจนถึงตอนนี้จะดึงเฉพาะข้อมูลจากหน้าแรกเท่านั้น หากต้องการเลื่อนไปยังหน้าถัดไป ให้คลิกที่สัญลักษณ์ "+" ของส่วนที่เลือกหน้า และเลือก "เลือก"

-

เลื่อนลงไปที่ด้านล่างสุดของหน้าแล้วคลิกถัดไป

-

คลิกสัญลักษณ์ “+” บนส่วนที่เลือกถัดไปและเลือกคลิก

-

ป๊อปอัปจะปรากฏขึ้นเพื่อถามว่านี่คือปุ่มหน้าถัดไปหรือไม่ เลือก "ใช่" และป้อนจำนวนหน้าที่ต้องการให้คลิก เราเขียน 2 หน้า ดังนั้นรวมแล้วเราจะรวบรวม 3 หน้า จากนั้นกดปุ่ม "ทำซ้ำเทมเพลตปัจจุบัน"

-

โครงการพร้อมแล้ว

-

เรียกใช้โครงการ: กดปุ่มรับข้อมูล

-

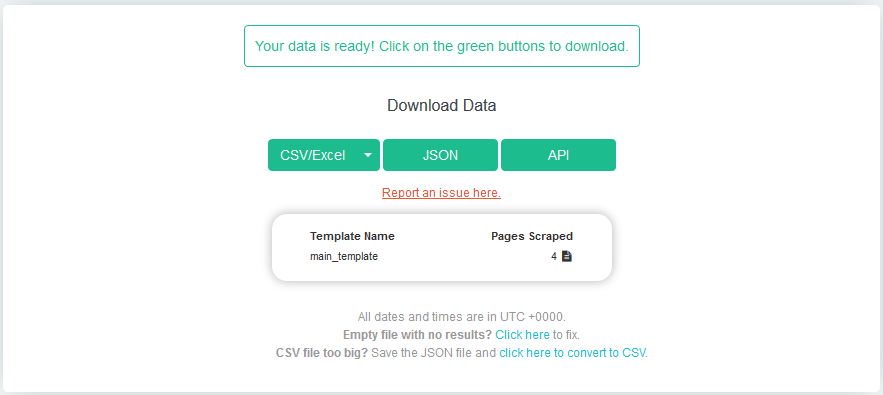

เลือก Run ภายในไม่กี่นาที ข้อมูลจะพร้อม เลือกรูปแบบไฟล์ที่คุณต้องการ

การขูดข้อมูล Reddit ด้วย Python (โค้ด)

เมื่อรู้วิธีขูดข้อมูล Reddit โดยใช้เครื่องมือที่ไม่ต้องใช้โค้ด คุณจะสงสัยว่าทำไมผู้คนถึงเลือกใช้สคริปต์การเขียนโปรแกรมสำหรับงานเดียวกัน

คำตอบนั้นอยู่ในอิสรภาพที่มาพร้อมกับวิธีการนี้

การใช้เครื่องมือขูดข้อมูล Reddit แบบไม่ต้องใช้โค้ด คุณจะสามารถขูดได้เฉพาะประเภทข้อมูลที่อนุญาตให้คุณขูดเท่านั้น นอกจากนี้ยังมีข้อจำกัดอื่นๆ เช่น ข้อจำกัดของหน้าหรือข้อจำกัดของโพสต์

คุณอาจสามารถหลีกเลี่ยงข้อจำกัดเหล่านี้ได้โดยอัปเกรดเป็นแผนพรีเมียม แต่นั่นอาจทำให้กระเป๋าเงินของคุณเสียหายได้ และนอกจากนี้ หากข้อกำหนดในการขูดข้อมูลของคุณซับซ้อน ผู้ขูดข้อมูลแบบไม่มีโค้ดบน Reddit ก็ไม่สามารถช่วยเหลือคุณได้

นี่คือเวลาที่คุณจะต้องหันไปขูดข้อมูล Reddit ด้วย Python หรือภาษาการเขียนโปรแกรมอื่นๆ

โดยการขูด Reddit ด้วย Python คุณจะไม่เพียงแต่สามารถดึงข้อมูลใดๆ และหน้าใดๆ ก็ได้เท่านั้น แต่คุณยังจะ โดยไม่ต้องจ่ายแม้แต่สตางค์แดงเดียว จะเป็นได้ก็ต่อเมื่อคุณรู้จักการเขียนโค้ดด้วยตัวเอง มิฉะนั้น คุณจะต้องจ้างผู้เชี่ยวชาญในการขูดข้อมูล />

มาดูวิธีการรวบรวมข้อมูลบน Reddit ด้วย Python กันดีกว่า:

-

ติดตั้งไลบรารีที่จำเป็น: ตรวจสอบให้แน่ใจว่าคุณได้ติดตั้งไลบรารีที่จำเป็น เช่น PRAW (Python Reddit API Wrapper) และ Pandas

-

สร้างแอป Reddit: ไปที่เว็บไซต์ของ Reddit และสร้างแอปใหม่ รับ ID ไคลเอนต์ ความลับไคลเอนต์ ชื่อผู้ใช้ และรหัสผ่าน

-

ตรวจสอบสิทธิ์: ใช้ข้อมูลประจำตัวที่ได้รับเพื่อตรวจสอบสิทธิ์กับ API ของ Reddit โดยใช้ PRAW

-

เลือก Subreddit: ระบุ subreddit ที่คุณต้องการขูด

-

ขูดข้อมูล: ใช้ PRAW เพื่อดึงโพสต์จาก subreddit ที่เลือก นั่นคือ ระบุจำนวนโพสต์และแอตทริบิวต์ที่ต้องการ

-

จัดเก็บข้อมูล:จัดเก็บข้อมูลที่คัดลอกมาในรูปแบบที่เหมาะสม เช่น DataFrame โดยใช้ Pandas

-

วิเคราะห์หรือแสดงภาพ: วิเคราะห์หรือแสดงภาพข้อมูลที่รวบรวมมาตามความจำเป็นสำหรับโครงการหรือการวิเคราะห์ของคุณ

รักษาความปลอดภัยกิจกรรมการขูดข้อมูลของคุณจากการถูกบล็อก

ตาม Redditข้อตกลงผู้ใช้ การเข้าถึงไซต์ผ่านระบบอัตโนมัติ และการรวบรวมข้อมูลจาก Reddit โดยไม่ได้รับความยินยอมล่วงหน้านั้นเป็นสิ่งต้องห้าม

อย่างไรก็ตาม ไม่มีข้อมูลมากนักเกี่ยวกับมาตรการป้องกันของ Reddit เพื่อป้องกันการทุจริต เช่น การแบน IP หรือการระงับบัญชี

นี่อาจบ่งชี้ว่า Reddit มีทัศนคติที่ผ่อนปรนต่อการขูดข้อมูล แต่ก็ยังมีโอกาสที่เครื่องมือขูดข้อมูลของคุณอาจพบอุปสรรค เช่น CAPTCHA ขีดจำกัดอัตรา หรือการระงับ

นี่คือAdsPower anti-detect browser ถูกสร้างมาเพื่อจัดการ AdsPower ทำให้เครื่องมือสแกนข้อมูลของคุณดูเหมือนผู้ใช้จริงผ่านมาตรการป้องกันลายนิ้วมือ เพื่อให้คุณสามารถสแกนข้อมูลได้อย่างราบรื่น

สมัครฟรี ใช้ AdsPower และรวบรวม subreddits ที่เป็นประโยชน์โดยไม่มีการรบกวน

คนยังอ่าน

- คุณสามารถสร้างรายได้จาก Temu ได้จริงหรือไม่? (คู่มือปี 2026)

คุณสามารถสร้างรายได้จาก Temu ได้จริงหรือไม่? (คู่มือปี 2026)

คุณสามารถสร้างรายได้จาก Temu ในปี 2026 ได้หรือไม่? เรียนรู้วิธีการสร้างรายได้จริง ๆ ผ่านการแนะนำเพื่อน การตลาดแบบพันธมิตร และการขาย รวมถึงเคล็ดลับอัจฉริยะเพื่อเพิ่มรายได้จาก Temu ของคุณให้สูงสุด

- วิธีย้ายข้อมูลจากบัญชี ChatGPT หนึ่งไปยังอีกบัญชีหนึ่ง

วิธีย้ายข้อมูลจากบัญชี ChatGPT หนึ่งไปยังอีกบัญชีหนึ่ง

เรียนรู้วิธีย้ายประวัติการสนทนา ChatGPT ระหว่างบัญชี ข้อมูลส่วนไหนย้ายได้ และวิธีจัดการแชทหลายบัญชีให้มีประสิทธิภาพ

- แก้ปัญหาเข้าสู่ระบบ Match.com ไม่ได้: วิธีกู้คืนการเข้าถึงด้วย Fingerprint Browser

แก้ปัญหาเข้าสู่ระบบ Match.com ไม่ได้: วิธีกู้คืนการเข้าถึงด้วย Fingerprint Browser

หาก Match.com ล็อกบัญชีหรือปฏิเสธบัญชีอีเมลของคุณ คู่มือนี้จะอธิบายสาเหตุที่แท้จริงและวิธีแก้ไขปัญหาให้หายขาดด้วย Fingerprint Browser

- เว็บไซต์และแอปหาคู่ที่ดีที่สุดในปี 2026: วิธีเลือกแพลตฟอร์มที่เหมาะสม

เว็บไซต์และแอปหาคู่ที่ดีที่สุดในปี 2026: วิธีเลือกแพลตฟอร์มที่เหมาะสม

สำรวจเว็บไซต์และแอปหาคู่ที่ดีที่สุดในปี 2026 เปรียบเทียบแพลตฟอร์มฟรีและแบบเสียค่าใช้จ่าย เรียนรู้วิธีเลือกอย่างปลอดภัย และจัดการบัญชีหาคู่หลายบัญชี

- วิธีการเช่าบัญชีโฆษณา Facebook: คู่มือภาคปฏิบัติสำหรับผู้ลงโฆษณาที่กำลังเติบโต

วิธีการเช่าบัญชีโฆษณา Facebook: คู่มือภาคปฏิบัติสำหรับผู้ลงโฆษณาที่กำลังเติบโต

คู่มือนี้อธิบายเกี่ยวกับการเช่าบัญชีโฆษณา Facebook และวิธีการขยายธุรกิจอย่างปลอดภัยด้วยบัญชีที่ได้รับอนุญาตจาก Meta โดยใช้ GDT Agency และ AdsPower